これは、このセクションの複数ページの印刷可能なビューです。 印刷するには、ここをクリックしてください.

Kubernetesブログ

- Kubernetes v1.33: 思い描いていたとおりに動作するようになったImage Pull Policy!

- Kubernetes v1.33: HorizontalPodAutoscalerの設定可能な許容値

- Kubernetes v1.33: Octarine

- kube-scheduler-simulatorの紹介

- Kubernetes v1.33の先行紹介

- Kubernetes v1.32: Penelope

- Kubernetes Upstream Training in Japanの取り組みの紹介

- Kubernetes 1.31: Fine-grained SupplementalGroups control

- Kubernetes 1.31: SPDYからWebSocketへのストリーミングの移行

- Kubernetes v1.31: キャッシュからの整合性のある読み込みによるクラスターパフォーマンスの向上

- Kubernetes v1.31: Elli

- Client-Goへのフィーチャーゲートの導入: 柔軟性と管理性を強化するために

- SIG Nodeの紹介

- Kubernetesの10年間の歴史

- Kubernetes史上最大の移行作業を完了

- Gateway API v1.1: サービスメッシュ、GRPCRoute、そして更なる進化

- DIY: Kubernetesで自分だけのクラウドを構築しよう(パート3)

- DIY: Kubernetesで自分だけのクラウドを構築しよう(パート2)

- DIY: Kubernetesで自分だけのクラウドを構築しよう(パート1)

- Kubernetes v1.30をそっと覗く

- CRI-O: OCIレジストリからのseccompプロファイルの適用

- SIG Cloud Providerの取り組みの紹介

- Kubernetesブッククラブを覗く

- Kubernetesでコンテナを別ファイルシステムに格納する設定方法

- SIG Releaseスポットライト(リリース・チーム・サブプロジェクト)

- フォレンジックコンテナ分析

- Kubernetes 1.26: PodDisruptionBudgetによって保護された不健全なPodに対する退避ポリシー

- Kubernetesにおけるフォレンジックコンテナチェックポイント処理

- 更新: dockershimの削除に関するFAQ

- Don't Panic: Kubernetes and Docker

Kubernetes v1.33: 思い描いていたとおりに動作するようになったImage Pull Policy!

思い描いていたとおりに動作するようになったImage Pull Policy!

Kubernetesには意外な挙動がいくつか存在しますが、imagePullPolicyの挙動もその一つかもしれません。

KubernetesがPodの実行を本質とするものであることを踏まえると、認証が必要なイメージに対してPodのアクセスを制限しようとする際に、10年以上前からissue 18787という形で注意点が存在していたことを知ると、意外に思うかもしれません。

この10年越しの問題が解決されるリリースは、非常に興奮すべきものです。

備考:

このブログ記事全体を通して「Podの認証情報」という用語が頻繁に使われます。 この文脈においては、この用語は、一般的にコンテナイメージのプルを認証するためにPodが利用できる認証情報全体を指します。IfNotPresent、たとえ本来持つべきでないとしても

この問題の要点は、imagePullPolicy: IfNotPresentという設定が、まさに文字通りの意味でしか動作せず、それ以上のことは一切行ってこなかったという点です。

ここで、とあるシナリオを考えてみましょう。

まず、Namespace X内のPod AがNode 1にスケジュールされ、プライベートリポジトリからimage Fooを必要とする状況を考えます。

イメージプル時の認証情報として、このPodはimagePullSecretsのSecret 1を参照しています。

Secret 1には、プライベートリポジトリからイメージをプルするために必要な認証情報が含まれています。

KubeletはPod Aから提供されたSecret 1の認証情報を使用し、レジストリからcontainer image Fooをプルすることになります。

これが意図した(かつ安全な)動作です。

しかし、ここからが興味深いところです。

Namespace Y内のPod Bも、たまたまNode 1にスケジュールされたとします。

このとき、予期しない(かつ潜在的に安全でない)事態が発生します。

Pod BはIfNotPresentのイメージプルポリシーを指定し、同じプライベートイメージを参照しているかもしれません。

しかし、Pod BはimagePullSecretsでSecret 1(あるいは本例では、いかなるSecretも)を指定していません。

KubeletがこのPodを実行しようとすると、IfNotPresentのポリシーが尊重されます。

Kubeletは、image Fooがすでにローカルに存在していることを確認し、そのimage FooをPod Bに提供します。

つまり、Pod Bはそもそも、そのイメージをプルする権限を示す認証情報を一切提供していないにもかかわらず、そのイメージを実行できてしまうのです。

異なるPodによってプルされたプライベートイメージを使用する

IfNotPresentは、イメージがノード上にすでに存在している場合にはimage Fooをプルすべきではありませんが、ノードにスケジュールされたすべてのPodが、過去にプルされたプライベートイメージへアクセスできてしまうというのは、セキュリティ上不適切な構成です。

これらのPodはそもそも、そのイメージをプルする権限を全く与えられていなかったのです。

IfNotPresent、ただし本来アクセス権がある場合に限る

Kubernetes v1.33では、SIG AuthとSIG Nodeがついにこの(非常に古くからある)問題への対応を開始し、適切な検証が行われるようになりました! 基本的な期待される挙動は変更されていません。 イメージが存在しない場合、Kubeletはそのイメージをプルしようとします。 その際には、各Podが提供する認証情報が使用されます。 この挙動は1.33以前と同様です。

イメージがすでに存在している場合、Kubeletの挙動は変化します。 これからは、KubeletはPodにそのイメージの使用を許可する前に、そのPodの認証情報を検証するようになります。

この機能の改修にあたっては、パフォーマンスとサービスの安定性も考慮されています。 同じ認証情報を使用するPodは、再認証を要求されることはありません。 これは、Podが同じKubernetesのSecretオブジェクトから認証情報を取得している場合には、たとえその認証情報がローテーションされていたとしても、当てはまります。

Never pull、ただし認証されている場合に限る

imagePullPolicy: Neverオプションは、イメージを取得しません。

ただし、コンテナイメージがすでにノード上に存在する場合、そのプライベートイメージを使用しようとするすべてのPodは、認証情報の提示が求められ、その認証情報は検証されます。

同じ認証情報を使用するPodは、再認証を要求されることはありません。 一方で、以前にそのイメージのプルに成功した認証情報を提示しないPodには、プライベートイメージの使用が許可されません。

Always pull、ただし認証されている場合に限る

imagePullPolicy: Alwaysは、これまでも意図おりに動作してきました。

イメージが要求されるたびに、そのリクエストはレジストリに送られ、レジストリ側で認証チェックが実行されます。

以前は、プライベートなコンテナイメージが、すでにイメージをプル済みのノード上で他のPodに再利用されないようにする唯一の手段は、Podのアドミッション時に強制的にAlwaysのイメージプルポリシーを適用することでした。

幸いにも、この方法はある程度パフォーマンスに優れていました。 プルされるのはイメージそのものではなく、イメージマニフェストだけだったからです。 しかしながら、それでもコストとリスクは存在していました。 新しいロールアウト、スケールアップ、またはPodの再起動の際には、イメージを提供するレジストリが認証チェックのために必ず利用可能でなければならず、その結果、クラスター内で稼働するサービスの安定性において、イメージレジストリがクリティカルパスに置かれることになります。

仕組みについて

この機能は、各ノードに存在する永続的なファイルベースのキャッシュに基づいて動作します。 以下は、この機能がどのように動作するかの簡略化された説明です。 完全な仕様については、KEP-2535をご参照ください。

初めてイメージをリクエストする際の処理の流れは、以下のとおりです:

- プライベートレジストリからイメージを要求するPodが、ノードにスケジュールされる。

- 要求されたイメージが、当該ノード上に存在しない。

- Kubeletは、そのイメージをプルしようとしている状態であることを示す記録を作成する。

- Kubeletは、Podにimage pull secretとして指定されたKubernetesのSecretから認証情報を抽出し、それを使用してプライベートレジストリからイメージを取得します。。

- イメージのプルに成功すると、Kubeletはその成功を記録する。この記録には、使用された認証情報(ハッシュ形式)および、それらの認証情報を取得するために使われたSecretの情報も含まれる。

- Kubeletは、元のプルしようとしている状態であることを示す記録を削除する。

- Kubeletは、プルに成功したことを示す記録を後の利用のために保持する。

後に、同じノードにスケジュールされた別のPodが、以前にプルされたプライベートイメージを要求した場合の処理は次のとおりです:

- Kubeletは、その新しいPodがプルのために提供した認証情報を確認する。

- その認証情報のハッシュ、またはその認証情報の元となったSecretが、以前のプル成功時に記録されたハッシュまたはSecretと一致する場合、そのPodには以前にプルされたイメージの使用が許可される。

- 認証情報またはその認証情報の元となるSecretが、そのイメージに関するプル成功記録の中に存在しない場合、Kubeletはその新しい認証情報を使ってリモートレジストリからの再プルを試み、認証フローを開始する。

試してみよう

Kubernetes v1.33では、この機能のアルファ版がリリースされました。

実際に試してみるには、バージョン1.33のKubeletにおいて、KubeletEnsureSecretPulledImagesフィーチャーゲートを有効にしてください。

この機能や追加のオプション設定の詳細については、Kubernetes公式ドキュメントのイメージの概要ページをご覧ください。

今後の予定

今後のリリースにおいて、以下の対応を予定しています:

- Kubeletイメージ認証プロバイダ用の投影サービスアカウントトークンとの連携を実現します。これにより、ワークロードに特化した新しいイメージプル認証情報の供給元が追加されます。

- この機能のパフォーマンスを計測し、将来的な変更の影響を評価するためのベンチマークスイートを作成します。

- 各イメージプル要求のたびにファイルを読み込む必要がなくなるように、インメモリキャッシュ層を実装します。

- 認証情報の有効期限をサポートし、以前に検証済みの認証情報でも強制的に再認証するようにします。

参加するには

これらの変更について詳しく理解するには、KEP-2535を読むのが最適です。

さらに関わりたい方は、Kubernetes Slackの#sig-auth-authenticators-devチャンネルで私たちにご連絡ください(招待を受けるにはhttps://slack.k8s.io/をご確認ください)。 また、隔週水曜日に開催されているSIG Authのミーティングへの参加も歓迎です。

Kubernetes v1.33: HorizontalPodAutoscalerの設定可能な許容値

この投稿では、Kubernetes 1.33で初めて利用可能になった新しいアルファ機能である、HorizontalPodAutoscalerの設定可能な許容値 について説明します。

これは何ですか?

水平Pod自動スケーリングは、Kubernetesのよく知られた機能であり、リソース使用率に基づいてレプリカを追加または削除することで、ワークロードのサイズを自動的に調整できます。

たとえば、Kubernetesクラスターで50個のレプリカを持つWebアプリケーションが稼働しているとします。 HorizontalPodAutoscaler(HPA)をCPU使用率に基づいてスケーリングするように構成し、目標使用率を75%に設定します。 現在の全レプリカにおけるCPU使用率が目標の75%を上回る90%であると仮定します。 このとき、HPAは次の式を使用して必要なレプリカ数を計算します。

この例の場合では、下記のようになります。

そのため、HPAは各Podの負荷を軽減するために、レプリカ数を50から60に増やします。 同様に、CPU使用率が75%を下回った場合は、HPAがそれに応じてレプリカ数を縮小します。 Kubernetesのドキュメントでは、スケーリングアルゴリズムの詳細な説明が提供されています。

小さなメトリクスの変動があるたびにレプリカが作成または削除されるのを防ぐために、Kubernetesはヒステリシスの仕組みを適用しています。 現在の値と目標値の差が10%を超えた場合にのみ、レプリカ数を変更します。 上記の例では、現在値と目標値の比率は\(90/75\)、すなわち目標を20%上回っており、10%の許容値を超えているため、スケールアップが実行されます。

この10%というデフォルトの許容値はクラスター全体に適用されるものであり、これまでのKubernetesのリリースでは細かく調整することができませんでした。 多くの用途には適していますが、10%の許容値が数十個のPodに相当するような大規模なデプロイメントには粗すぎます。 その結果、コミュニティでは、この値を調整可能にしてほしいという要望が以前から寄せられてきました。

Kubernetes v1.33では、これが可能になりました。

どうやって使うのか?

Kubernetes v1.33クラスターでHPAConfigurableToleranceフィーチャーゲートを有効にした後、HorizontalPodAutoscalerオブジェクトに対して希望する許容値を設定できます。

許容値はspec.behavior.scaleDownおよびspec.behavior.scaleUpフィールドの下に指定され、スケールアップとスケールダウンで異なる値を設定することが可能です。

典型的な使い方としては、スケールアップには小さな許容範囲(スパイクに素早く反応するため)、スケールダウンには大きな許容範囲(メトリクスの小さな変動に対してレプリカを過剰に追加・削除しないようにするため)を指定することが挙げられます。

たとえば、スケールダウンに対して5%の許容値を、スケールアップに対して許容値を指定しないHPAは、次のようになります。

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: my-app

spec:

...

behavior:

scaleDown:

tolerance: 0.05

scaleUp:

tolerance: 0

すべての詳細を知りたい!

すべての技術的な詳細については、KEP-4951を参照してください。 また、issue 4951をフォローすることで、この機能の安定版への移行についての通知を受け取ることができます。

Kubernetes v1.33: Octarine

編集者: Agustina Barbetta, Aakanksha Bhende, Udi Hofesh, Ryota Sawada, Sneha Yadav

前回のリリースと同様に、Kubernetes v1.33リリースでは新しいGA、ベータ、アルファの機能が導入されています。 高品質なリリースの継続的な提供は、私たちの開発サイクルの強さとコミュニティからの活発なサポートを示しています。

このリリースには64個の機能改善が含まれています。 それらのうち、GAへの昇格が18個、ベータへの移行が20個、アルファとしての導入が24個、機能の非推奨化及び撤回が2個となっています。

また、このリリースにはいくつかの注目すべき非推奨化と削除があります。 まだ古いバージョンのKubernetesを実行している場合は、これらに必ず目を通してください。

リリースのテーマとロゴ

Kubernetes v1.33のテーマはOctarine: 魔法の色1で、テリー・プラチェットの ディスクワールド シリーズに着想を得ています。

このリリースは、Kubernetesがエコシステム全体で可能にするオープンソースの魔法2を強調しています。

ディスクワールドの世界に詳しい方なら、"見えざる大学"の塔の上に止まった小さな沼ドラゴンが、アンク・モルポークの街の上に64の星3と共に浮かぶKubernetesの月を見上げる様子を思い浮かべていることでしょう。

Kubernetesが10年の節目を迎え新たな10年へ踏み出すにあたり、私たちはメンテナーの魔術、新しいコントリビューターの好奇心、そしてプロジェクトを推進する協力的な精神を祝福します。 v1.33リリースは、プラチェットが書いたように、「やり方を知っていても、それはまだ魔法だ」 ということを思い出させてくれます。 Kubernetesのコードベースの詳細をすべて知っていたとしても、リリースサイクルの終わりに立ち止まってみると、Kubernetesはまだ魔法のままであることがわかるでしょう。

Kubernetes v1.33は、真に卓越したものを生み出すために世界中の何百人ものコントリビューター4が協力する、オープンソースイノベーションの持続的な力の証です。 あらゆる新機能の背後には、プロジェクトを維持・改善したり、安全性や信頼性を担保したり、計画通りにリリースしたりといったKubernetesコミュニティの働きがあります。

1. Octarineはディスクワールド世界の神話上の8番目の色で、「蛍光の緑がかった黄紫色」と表現される架空の色です。

秘術に調律された人々—魔法使い、魔女、そしてもちろん猫にのみ見えます。

一般人は目を閉じた時のみこの色を感じることができるとされています。

そして時々、IPテーブルのルールを長時間見つめてきた人にも見えるようになります。

2. 「十分に発達した技術は魔法と区別がつかない」ですよね…?

3. v1.33にも64のKEP(Kubernetes Enhancement Proposals)が含まれていますが、これは偶然ではありません。

4. v1.33のプロジェクト活動状況セクションをご覧ください 🚀

主なアップデート情報

Kubernetes v1.33は新機能と改善点が満載です。 このセクションでは、リリースチームが特に注目して欲しい、選りすぐりのアップデート内容をご紹介します!

GA: サイドカーコンテナ

サイドカーパターンでは、ネットワーキング、ロギング、メトリクス収集などの分野における追加機能を処理するために、別途補助的なコンテナをデプロイする必要があります。 サイドカーコンテナはv1.33でGAに昇格しました。

Kubernetesでは、restartPolicy: Alwaysが設定された、特別な種類のinitコンテナとしてサイドカーを実装しています。

サイドカーは、アプリケーションコンテナより先に起動し、Podのライフサイクル全体を通じて実行され続け、アプリケーションコンテナの終了を待ってから自動的に終了することが保証されます。

さらに、サイドカーはprobe(startup、readiness、liveness)を使用して動作状態を通知できる他、メモリ不足時の早期終了を防ぐため、Out-Of-Memory(OOM)スコア調整がプライマリコンテナと揃えられています。

詳細については、サイドカーコンテナをお読みください。

この作業はSIG Nodeが主導したKEP-753: Sidecar Containersの一環として行われました。

ベータ: Podの垂直スケーリングのためのインプレースなリソースリサイズ

ワークロードはDeployment、StatefulSetなどのAPIを使用して定義できます。

これらはメモリやCPUリソース、また実行すべきPodの数(レプリカ数)を含む、実行されるべきPodのテンプレートを示しています。

ワークロードはPodのレプリカ数を更新することで水平方向にスケールしたり、Podのコンテナに必要なリソースを更新することで垂直方向にスケールしたりできます。

この機能改善が入る前、Podのspecで定義されたコンテナリソースは不変であり、これらの詳細をPodテンプレート内で更新するにはPodの置き換えが必要でした。

しかし、再起動無しで既存のPodのリソース設定を動的に更新できるとしたらどうでしょうか?

KEP-1287は、まさにそのようなインプレースPod更新を可能にするためのものです。 これはv1.27でアルファとしてリリースされ、v1.33でベータに昇格しました。 これにより、ステートフルなプロセスをダウンタイムなしで垂直方向にスケールアップしたり、トラフィックが少ない時シームレスにスケールダウンすることができます。 さらには起動時に大きなリソースを割り当てて、初期設定が完了したら削減したりするなど、さまざまな可能性が開かれます。

この作業はSIG NodeとSIG Autoscalingが主導したKEP-1287: In-Place Update of Pod Resourcesの一環として行われました。

アルファ: .kubercによるkubectl向けユーザー設定の新しい記述オプション

v1.33にて、kubectlは新しいアルファ機能として、ユーザー設定をクラスター設定と分けて明示的に記述するファイル、.kubercを導入します。

このファイルにはkubectlのエイリアスや上書き設定(例えばServer-Side Applyをデフォルトで使用するなど)を含めることができますが、クラスター認証情報やホスト情報はkubeconfigに残しておく必要があります。

この分離によって、対象クラスターや使用するkubeconfigに関わらず、kubectlの操作に関わるユーザー設定は同じ物を使い回せるようになります。

このアルファ機能を有効にするためには、環境変数KUBECTL_KUBERC=trueを設定し、.kuberc設定ファイルを作成して下さい。

デフォルトの状態では、kubectlは~/.kube/kubercにこのファイルが無いか探します。

--kubercフラグを使用すると、代わりの場所を指定することもできます。

例: kubectl --kuberc /var/kube/rc

この作業はSIG CLIが主導したKEP-3104: Separate kubectl user preferences from cluster configsの一環として行われました。

GAに昇格した機能

これはv1.33リリース後にGAとなった改善点の一部です。

インデックス付きJobのインデックスごとのバックオフ制限

このリリースでは、インデックス付きJobのインデックスごとにバックオフ制限を設定できる機能がGAに昇格しました。

従来、Kubernetes JobのbackoffLimitパラメーターは、Job全体が失敗とみなされる前の再試行回数を指定していました。

この機能強化により、インデックス付きJob内の各インデックスが独自のバックオフ制限を持つことができるようになり、個々のタスクの再試行動作をより細かく制御できるようになりました。

これにより、特定のインデックスの失敗がJob全体を早期に終了させることなく、他のインデックスが独立して処理を継続できるようになります。

この作業はSIG Appsが主導したKEP-3850: Backoff Limit Per Index For Indexed Jobsの一環として行われました。

Job成功ポリシー

.spec.successPolicyを使用してユーザーはどのPodインデックスが成功する必要があるか(succeededIndexes)、何個のPodが成功する必要があるか(succeededCount)、またはその両方の組み合わせを指定できます。

この機能は、部分的な完了で十分なシミュレーションやリーダーの成功だけがJobの全体的な結果を決定するリーダー・ワーカーパターンなど、さまざまなワークロードに利点をもたらします。

この作業はSIG Appsが主導したKEP-3998: Job success/completion policyの一環として行われました。

バインドされたServiceAccountトークンのセキュリティ改善

この機能強化では一意のトークン識別子(すなわちJWT IDクレーム、JTIとも呼ばれる)やノード情報をトークン内に含めることで、より正確な検証と監査を可能にする機能などが導入されました。 さらに、ノード固有の制限をサポートし、トークンが指定されたノードでのみ使用可能であることを保証することで、トークンの不正使用や潜在的なセキュリティ侵害のリスクを低減します。 これらの改善は現在一般提供され、Kubernetesクラスター内のサービスアカウントトークンの全体的なセキュリティ態勢を強化することを目的としています。

この作業はSIG Authが主導したKEP-4193: Bound service account token improvementsの一環として行われました。

kubectlでのサブリソースサポート

--subresource引数が現在kubectlのサブコマンド(get、patch、edit、apply、replaceなど)で一般提供されるようになり、ユーザーはそれらをサポートするすべてのリソースのサブリソースを取得および更新できるようになりました。

サポートされているサブリソースの詳細については、Subresourcesをご覧ください。

この作業はSIG CLIが主導したKEP-2590: Add subresource support to kubectlの一環として行われました。

複数のサービスCIDR

この機能強化では、サービスIPの割り当てロジックの新しい実装が導入されました。

クラスター全体で、type: ClusterIPの各サービスには一意のIPアドレスが割り当てられる必要があります。

既に割り当てられている特定のClusterIPでサービスを作成しようとすると、エラーが返されます。

更新されたIPアドレス割り当てロジックは、ServiceCIDRとIPAddressという2つの新しく安定化したAPIオブジェクトを使用します。

現在一般提供されているこれらのAPIにより、クラスター管理者は(新しいServiceCIDRオブジェクトを作成することで)type: ClusterIPサービスに利用可能なIPアドレスの数を動的に増やすことができます。

この作業はSIG Networkが主導したKEP-1880: Multiple Service CIDRsの一環として行われました。

kube-proxyのnftablesバックエンド

kube-proxyのnftablesバックエンドがGAになり、Kubernetesクラスター内のサービス実装のパフォーマンスとスケーラビリティを大幅に向上させる新しい実装が追加されました。

互換性の理由から、Linuxノードではデフォルトでiptablesのままです。

試してみたい場合はMigrating from iptables mode to nftablesをご確認ください。

この作業はSIG Networkが主導したKEP-3866: nftables kube-proxy backendの一環として行われました。

trafficDistribution: PreferCloseによるTopology Aware Routing

このリリースでは、Topology Aware Routingとトラフィック分散がGAに昇格し、マルチゾーンクラスターでのサービストラフィックを最適化できるようになりました。

EndpointSliceのTopology Aware Hintによりkube-proxyなどのコンポーネントは同じゾーン内のエンドポイントへのトラフィックルーティングを優先できるようになり、レイテンシーとクロスゾーンデータ転送コストが削減されます。

これを基に、Serviceの仕様にtrafficDistributionフィールドが追加され、PreferCloseオプションによりネットワークトポロジーに基づいて最も近い利用可能なエンドポイントにトラフィックが誘導されます。

この構成はゾーン間通信を最小限に抑えることでパフォーマンスとコスト効率を向上させます。

この作業はSIG Networkが主導したKEP-4444: Traffic Distribution for ServicesとKEP-2433: Topology Aware Routingの一環として行われました。

SMT非対応ワークロードを拒否するオプション

この機能はCPUマネージャーにポリシーオプションを追加し、Simultaneous Multithreading(SMT)構成に適合しないワークロードを拒否できるようにしました。 現在一般提供されているこの機能強化により、PodがCPUコアの排他的使用を要求する場合、CPUマネージャーはSMT対応システムで完全なコアペア(プライマリスレッドと兄弟スレッド両方を含む)の割り当てを強制できるようになり、ワークロードが意図しない方法でCPUリソースを共有するシナリオを防止します。

この作業はSIG Nodeが主導したKEP-2625: node: cpumanager: add options to reject non SMT-aligned workloadの一環として行われました。

matchLabelKeysとmismatchLabelKeysを使用したPodアフィニティまたはアンチアフィニティの定義

matchLabelKeysとmismatchLabelKeysフィールドがPodアフィニティ条件で利用可能になり、ユーザーはPodが共存する(アフィニティ)または共存しない(アンチアフィニティ)べき範囲を細かく制御できるようになりました。

これらの新しく安定化したオプションは、既存のlabelSelectorメカニズムを補完します。

affinityフィールドは、多用途なローリングアップデートの強化されたスケジューリングや、グローバル構成に基づいてツールやコントローラーによって管理されるサービスの分離を容易にします。

この作業はSIG Schedulingが主導したKEP-3633: Introduce MatchLabelKeys to Pod Affinity and Pod Anti Affinityの一環として行われました。

Podトポロジー分散制約スキューの計算時にtaintとtolerationを考慮する

この機能強化はPodTopologySpreadにnodeAffinityPolicyとnodeTaintsPolicyという2つのフィールドを導入しました。

これらのフィールドにより、ユーザーはノード間のPod分散のスキュー(偏り)を計算する際にノードアフィニティルールとノードテイントを考慮すべきかどうかを指定できます。

デフォルトでは、nodeAffinityPolicyはHonorに設定されており、Podのノードアフィニティまたはセレクターに一致するノードのみが分散計算に含まれることを意味します。

nodeTaintsPolicyはデフォルトでIgnoreに設定されており、指定されない限りノードテイントは考慮されないことを示します。

この機能強化によりPod配置のより細かい制御が可能になり、Podがアフィニティとテイント許容の両方の要件を満たすノードにスケジュールされることを保証し、制約を満たさないためにPodが保留状態のままになるシナリオを防止します。

この作業はSIG Schedulingが主導したKEP-3094: Take taints/tolerations into consideration when calculating PodTopologySpread skewの一環として行われました。

Volume Populators

v1.24でベータとしてリリースされた後、Volume Populators はv1.33でGAに昇格しました。

この新しく安定化した機能は、ユーザーがPersistentVolumeClaim(PVC)クローンやボリュームスナップショットだけでなく、様々なソースからのデータでボリュームを事前に準備する方法を提供します。

このメカニズムはPersistentVolumeClaim内のdataSourceRefフィールドに依存しています。

このフィールドは既存のdataSourceフィールドよりも柔軟性が高く、カスタムリソースをデータソースとして使用することができます。

特別なコントローラーであるvolume-data-source-validatorは、VolumePopulatorという名前のAPI種別のための新しく安定化したCustomResourceDefinition(CRD)と共に、これらのデータソース参照を検証します。

VolumePopulator APIにより、ボリュームポピュレーターコントローラーはサポートするデータソースのタイプを登録できます。

ボリュームポピュレーターを使用するには、適切なCRDでクラスターをセットアップする必要があります。

この作業はSIG Storageが主導したKEP-1495: Generic data populatorsの一環として行われました。

PersistentVolumeの再利用ポリシーを常に尊重する

この機能強化はPersistent Volume(PV)の再利用ポリシーが一貫して尊重されない問題に対処したもので、ストレージリソースのリークを防ぎます。

具体的にはPVがその関連するPersistent Volume Claim(PVC)より先に削除された場合、再利用ポリシー(Delete)が実行されず、基盤となるストレージアセットがそのまま残ってしまう可能性がありました。

これを緩和するために、Kubernetesは関連するPVにファイナライザーを設定し、削除順序に関係なく再利用ポリシーが適用されるようになりました。

この機能強化により、ストレージリソースの意図しない保持を防ぎ、PVライフサイクル管理の一貫性を維持します。

この作業はSIG Storageが主導したKEP-2644: Always Honor PersistentVolume Reclaim Policyの一環として行われました。

ベータの新機能

これはv1.33リリース後にベータとなった改善点の一部です。

Windowsのkube-proxyにおけるDirect Service Return (DSR)のサポート

DSRは、ロードバランサーを経由するリターントラフィックがロードバランサーをバイパスしてクライアントに直接応答できるようにすることでパフォーマンスを最適化します。 これによりロードバランサーの負荷が軽減され、全体的なレイテンシーも低減されます。 Windows上のDSRに関する情報は、Direct Server Return (DSR) in a nutshellをお読みください。

v1.14で最初に導入されたDSRのサポートは、KEP-5100: Support for Direct Service Return (DSR) and overlay networking in Windows kube-proxyの一環としてSIG Windowsによりベータに昇格しました。

構造化パラメーターのサポート

構造化パラメーターのサポートはKubernetes v1.33でベータ機能として継続される中、Dynamic Resource Allocation(DRA)のこの中核部分に大幅な改善が見られました。

新しいv1beta2バージョンはresource.k8s.io APIを簡素化し、名前空間クラスターのeditロールを持つ一般ユーザーが現在DRAを使用できるようになりました。

kubeletは現在シームレスなアップグレードサポートを含み、DaemonSetとしてデプロイされたドライバーがローリングアップデートメカニズムを使用できるようになっています。

DRA実装では、これによりResourceSliceの削除と再作成が防止され、アップグレード中も変更されないままにすることができます。

さらに、ドライバーの登録解除後にkubeletがクリーンアップを行う前に30秒の猶予期間が導入され、ローリングアップデートを使用しないドライバーのサポートが向上しました。

この作業はSIG Node、SIG Scheduling、SIG Autoscalingを含む機能横断チームであるWG Device ManagementによるKEP-4381: DRA: structured parametersの一環として行われました。

ネットワークインターフェース向けDynamic Resource Allocation(DRA)

v1.32で導入されたDRAによるネットワークインターフェースデータの標準化された報告がv1.33でベータに昇格しました。 これにより、よりネイティブなKubernetesネットワークの統合が可能になり、ネットワークデバイスの開発と管理が簡素化されます。 これについては以前にv1.32リリース発表ブログで説明されています。

この作業はSIG Network、SIG Node、およびWG Device Managementが主導したKEP-4817: DRA: Resource Claim Status with possible standardized network interface dataの一環として行われました。

スケジューラーがactiveQにPodを持たない場合に、スケジュールされていないPodを早期に処理

この機能はキュースケジューリングの動作を改善します。

裏側では、スケジューラーはactiveQが空の場合に、エラーによってバックオフされていないPodをbackoffQからポップすることでこれを実現しています。

以前は、activeQが空の場合でもスケジューラーはアイドル状態になってしまいましたが、この機能強化はそれを防止することでスケジューリング効率を向上させます。

この作業はSIG Schedulingが主導したKEP-5142: Pop pod from backoffQ when activeQ is emptyの一環として行われました。

Kubernetesスケジューラーにおける非同期プリエンプション

プリエンプションは、優先度の低いPodを退避させることで、優先度の高いPodが必要なリソースを確保できるようにします。 v1.32でアルファとして導入された非同期プリエンプションがv1.33でベータに昇格しました。 この機能強化により、Podを削除するためのAPIコールなどの重い操作が並行して処理されるようになり、スケジューラーは遅延なく他のPodのスケジューリングを継続できます。 この改善は特にPodの入れ替わりが激しいクラスターやスケジューリングの失敗が頻繁に発生するクラスターで有益であり、より効率的で回復力のあるスケジューリングプロセスを確保します。

この作業はSIG Schedulingが主導したKEP-4832: Asynchronous preemption in the schedulerの一環として行われました。

ClusterTrustBundle

X.509トラストアンカー(ルート証明書)を保持するために設計されたクラスタースコープリソースであるClusterTrustBundleがv1.33でベータに昇格しました。 このAPIにより、クラスター内の証明書署名者がX.509トラストアンカーをクラスターワークロードに公開および通信することが容易になります。

この作業はSIG Authが主導したKEP-3257: ClusterTrustBundles (previously Trust Anchor Sets)の一環として行われました。

きめ細かいSupplementalGroupsの制御

v1.31で導入されたこの機能はv1.33でベータに昇格し、現在はデフォルトで有効になっています。

クラスターでフィーチャーゲートのSupplementalGroupsPolicyが有効になっている場合、PodのsecurityContext内のsupplementalGroupsPolicyフィールドは2つのポリシーをサポートします:

デフォルトのMergeポリシーはコンテナイメージの/etc/groupファイルからのグループと指定されたグループを結合することで後方互換性を維持し、新しいStrictポリシーは明示的に定義されたグループのみを適用します。

この機能強化は、コンテナイメージからの暗黙的なグループメンバーシップが意図しないファイルアクセス権限につながり、ポリシー制御をバイパスする可能性があるセキュリティ上の懸念に対処するのに役立ちます。

この作業はSIG Nodeが主導したKEP-3619: Fine-grained SupplementalGroups controlの一環として行われました。

イメージをボリュームとしてマウントする機能をサポート

v1.31で導入されたPodでOpen Container Initiative(OCI)イメージをボリュームとして使用する機能のサポートがベータに昇格しました。 この機能により、ユーザーはPod内でイメージ参照をボリュームとして指定し、コンテナ内でボリュームマウントとして再利用できるようになります。 これにより、ボリュームデータを別々にパッケージ化し、メインイメージに含めることなくPod内のコンテナ間で共有する可能性が開かれ、脆弱性を減らしイメージ作成を簡素化します。

この作業はSIG NodeとSIG Storageが主導したKEP-4639: VolumeSource: OCI Artifact and/or Imageの一環として行われました。

Linux Podにおけるユーザー名前空間のサポート

執筆時点で最も古いオープンなKEPの1つであるKEP-127は、Pod用のLinuxユーザー名前空間を使用したPodセキュリティの改善です。 このKEPは2016年後半に最初に提案され、複数の改訂を経て、v1.25でアルファリリース、v1.30で初期ベータ(デフォルトでは無効)となり、v1.33の一部としてデフォルトで有効なベータに移行しました。

このサポートは、手動でpod.spec.hostUsersを指定してオプトインしない限り、既存のPodに影響を与えません。

v1.30の先行紹介ブログで強調されているように、これは脆弱性を軽減するための重要なマイルストーンです。

この作業はSIG Nodeが主導したKEP-127: Support User Namespaces in podsの一環として行われました。

PodのprocMountオプション

v1.12でアルファとして導入され、v1.31でデフォルト無効のベータだったprocMountオプションが、v1.33でデフォルト有効のベータに移行しました。

この機能強化はユーザーが/procファイルシステムへのアクセスを細かく調整できるようにすることでPod分離を改善します。

具体的には、PodのsecurityContextにフィールドを追加し、特定の/procパスをマスクしたり読み取り専用としてマークするデフォルトの動作をオーバーライドできるようにします。

これは特に、ユーザーがユーザー名前空間を使用してKubernetes Pod内で非特権コンテナを実行したい場合に便利です。

通常、コンテナランタイム(CRI実装を介して)は厳格な/procマウント設定で外部コンテナを起動します。

しかし、非特権Pod内でネストされたコンテナを正常に実行するには、ユーザーはそれらのデフォルト設定を緩和するメカニズムが必要であり、この機能はまさにそれを提供します。

この作業はSIG Nodeが主導したKEP-4265: add ProcMount optionの一環として行われました。

NUMAノード間でCPUを分散させるCPUManagerポリシー

この機能はCPUManagerに、単一ノードに集中させるのではなく非一様メモリアクセス(NUMA)ノード間でCPUを分散させる新しいポリシーオプションを追加します。 これにより複数のNUMAノード間でワークロードのバランスを取ることでCPUリソースの割り当てを最適化し、マルチNUMAシステムにおけるパフォーマンスとリソース使用率を向上させます。

この作業はSIG Nodeが主導したKEP-2902: Add CPUManager policy option to distribute CPUs across NUMA nodes instead of packing themの一環として行われました。

コンテナのPreStopフックのゼロ秒スリープ

Kubernetes 1.29ではPodのpreStopライフサイクルフックにSleepアクションが導入され、コンテナが終了する前に指定された時間だけ一時停止できるようになりました。

これにより、接続のドレイン(排出)やクリーンアップ操作などのタスクを容易にするコンテナのシャットダウンを遅らせるための簡単な方法が提供されます。

preStopフックのSleepアクションは、現在ベータ機能としてゼロ秒の時間を受け付けることができます。

これにより、preStopフックが必要だが遅延が不要な場合に便利な、無操作(no-op)のpreStopフックを定義できるようになります。

この作業はSIG Nodeが主導したKEP-3960: Introducing Sleep Action for PreStop HookおよびKEP-4818: Allow zero value for Sleep Action of PreStop Hookの一環として行われました。

Kubernetesネイティブ型の宣言的検証のための内部ツール

ひそかに、Kubernetesの内部はオブジェクトとオブジェクトへの変更を検証するための新しいメカニズムの使用を開始しています。

Kubernetes v1.33では、Kubernetesコントリビューターが宣言的な検証ルールを生成するために使用する内部ツールvalidation-genを導入しています。

全体的な目標は、開発者が検証制約を宣言的に指定できるようにすることでAPI検証の堅牢性と保守性を向上させ、手動コーディングエラーを減らし、コードベース全体での一貫性を確保することです。

この作業はSIG API Machineryが主導したKEP-5073: Declarative Validation Of Kubernetes Native Types With validation-genの一環として行われました。

アルファの新機能

これはv1.33リリース後にアルファとなった改善点の一部です。

HorizontalPodAutoscalerの設定可能な許容値

この機能は、HorizontalPodAutoscaler設定可能な許容値を導入し、小さなメトリクス変動に対するスケーリング反応を抑制します。

この作業はSIG Autoscalingが主導したKEP-4951: Configurable tolerance for Horizontal Pod Autoscalersの一環として行われました。

設定可能なコンテナの再起動遅延

CrashLoopBackOffの処理方法を微調整できる機能です。

この作業はSIG Nodeが主導したKEP-4603: Tune CrashLoopBackOffの一環として行われました。

カスタムコンテナの停止シグナル

Kubernetes v1.33より前では、停止シグナルはコンテナイメージ定義内でのみ設定可能でした(例えば、イメージメタデータのStopSignalフィールドを介して)。

終了動作を変更したい場合は、カスタムコンテナイメージをビルドする必要がありました。

Kubernetes v1.33で(アルファの)フィーチャーゲートであるContainerStopSignalsを有効にすることで、Pod仕様内で直接カスタム停止シグナルを定義できるようになりました。

これはコンテナのlifecycle.stopSignalフィールドで定義され、Podのspec.os.nameフィールドが存在する必要があります。

指定されない場合、コンテナはイメージで定義された停止シグナル(存在する場合)、またはコンテナランタイムのデフォルト(通常Linuxの場合はSIGTERM)にフォールバックします。

この作業はSIG Nodeが主導したKEP-4960: Container Stop Signalsの一環として行われました。

豊富なDRA機能強化

Kubernetes v1.33は、今日の複雑なインフラストラクチャ向けに設計された機能を備えたDynamic Resource Allocation (DRA)の開発を継続しています。 DRAはPod間およびPod内のコンテナ間でリソースを要求および共有するためのAPIです。 通常、それらのリソースはGPU、FPGA、ネットワークアダプターなどのデバイスです。

以下はv1.33で導入されたすべてのアルファのDRAのフィーチャーゲートです:

- ノードテイントと同様に、フィーチャーゲートの

DRADeviceTaintsを有効にすることで、デバイスはTaintとTolerationをサポートします。 管理者またはコントロールプレーンコンポーネントはデバイスにテイントを付けて使用を制限できます。 テイントが存在する間、それらのデバイスに依存するPodのスケジューリングを一時停止したり、テイントされたデバイスを使用するPodを退避させたりすることができます。 - フィーチャーゲートの

DRAPrioritizedListを有効にすることで、DeviceRequestsはfirstAvailableという新しいフィールドを取得します。 このフィールドは順序付けられたリストで、ユーザーが特定のハードウェアが利用できない場合に何も割り当てないことを含め、リクエストが異なる方法で満たされる可能性を指定できるようにします。 - フィーチャーゲートの

DRAAdminAccessを有効にすると、resource.k8s.io/admin-access: "true"でラベル付けされた名前空間内でResourceClaimまたはResourceClaimTemplateオブジェクトを作成する権限を持つユーザーのみがadminAccessフィールドを使用できます。 これにより、管理者以外のユーザーがadminAccess機能を誤用できないようになります。 - v1.31以降、デバイスパーティションの使用が可能でしたが、ベンダーはデバイスを事前にパーティション分割し、それに応じて通知する必要がありました。

v1.33でフィーチャーゲートの

DRAPartitionableDevicesを有効にすることで、デバイスベンダーは重複するものを含む複数のパーティションを通知できます。 Kubernetesスケジューラーはワークロード要求に基づいてパーティションを選択し、競合するパーティションの同時割り当てを防止します。 この機能により、ベンダーは割り当て時に動的にパーティションを作成する機能を持ちます。 割り当てと動的パーティショニングは自動的かつユーザーに透過的に行われ、リソース使用率の向上を可能にします。

これらのフィーチャーゲートは、フィーチャーゲートのDynamicResourceAllocationも有効にしない限り効果がありません。

この作業はSIG Node、SIG Scheduling、SIG Authが主導した KEP-5055: DRA: device taints and tolerations、 KEP-4816: DRA: Prioritized Alternatives in Device Requests、 KEP-5018: DRA: AdminAccess for ResourceClaims and ResourceClaimTemplates、 およびKEP-4815: DRA: Add support for partitionable devicesの一環として行われました。

IfNotPresentとNeverのイメージに対する認証を行う堅牢なimagePullPolicy

この機能により、ユーザーはイメージがノード上に既に存在するかどうかに関わらず、新しい資格情報セットごとにkubeletがイメージプル認証チェックを要求することを確実にできます。

この作業はSIG Authが主導したKEP-2535: Ensure secret pulled imagesの一環として行われました。

Downward APIを通じて利用可能なノードトポロジーラベル

この機能により、ノードトポロジーラベルがダウンワードAPIを通じて公開されるようになります。 Kubernetes v1.33より前では、基盤となるノードについてKubernetes APIに問い合わせるために初期化コンテナを使用する回避策が必要でした。 このアルファ機能により、ワークロードがノードトポロジー情報にアクセスする方法が簡素化されます。

この作業はSIG Nodeが主導したKEP-4742: Expose Node labels via downward APIの一環として行われました。

生成番号と観測された生成番号によるより良いPodステータス

この変更以前は、metadata.generationフィールドはPodでは使用されていませんでした。

metadata.generationをサポートするための拡張に加えて、この機能はstatus.observedGenerationを導入し、より明確なPodステータスを提供します。

この作業はSIG Nodeが主導したKEP-5067: Pod Generationの一環として行われました。

kubeletのCPU Managerによる分割レベル3キャッシュアーキテクチャのサポート

これまでのkubeletのCPU Managerは分割L3キャッシュアーキテクチャ(Last Level Cache、またはLLCとも呼ばれる)を認識せず、分割L3キャッシュを考慮せずにCPU割り当てを分散させる可能性があり、ノイジーネイバー問題を引き起こす可能性がありました。 このアルファ機能はCPU Managerを改善し、より良いパフォーマンスのためにCPUコアをより適切に割り当てます。

この作業はSIG Nodeが主導したKEP-5109: Split L3 Cache Topology Awareness in CPU Managerの一環として行われました。

スケジューリング改善のためのPSI(Pressure Stall Information)メトリクス

この機能は、Linuxノードにcgroupv2を使用してPSI統計とメトリクスを提供するサポートを追加します。 これによりリソース不足を検出し、Podスケジューリングのためのより細かい制御をノードに提供できます。

この作業はSIG Nodeが主導したKEP-4205: Support PSI based on cgroupv2の一環として行われました。

kubeletによるシークレットレスイメージPull

kubeletのオンディスク認証情報プロバイダーが、オプションでKubernetes ServiceAccount(SA)トークンの取得をサポートするようになりました。 これにより、クラウドプロバイダーはOIDC互換のアイデンティティソリューションとより適切に統合でき、イメージレジストリとの認証が簡素化されます。

この作業はSIG Authが主導したKEP-4412: Projected service account tokens for Kubelet image credential providersの一環として行われました。

v1.33での昇格、非推奨化、および削除

GAへの昇格

これは安定版(一般提供、GAとも呼ばれる)に昇格したすべての機能を一覧にしたものです。 アルファからベータへの昇格や新機能を含む更新の完全なリストについては、リリースノートをご覧ください。

このリリースには、GAに昇格した合計18の機能強化が含まれています:

- Take taints/tolerations into consideration when calculating PodTopologySpread skew

- Introduce

MatchLabelKeysto Pod Affinity and Pod Anti Affinity - Bound service account token improvements

- Generic data populators

- Multiple Service CIDRs

- Topology Aware Routing

- Portworx file in-tree to CSI driver migration

- Always Honor PersistentVolume Reclaim Policy

- nftables kube-proxy backend

- Deprecate status.nodeInfo.kubeProxyVersion field

- Add subresource support to kubectl

- Backoff Limit Per Index For Indexed Jobs

- Job success/completion policy

- Sidecar Containers

- CRD Validation Ratcheting

- node: cpumanager: add options to reject non SMT-aligned workload

- Traffic Distribution for Services

- Recursive Read-only (RRO) mounts

非推奨化と削除

Kubernetesの開発と成熟に伴い、プロジェクト全体の健全性を向上させるために機能が非推奨化されたり、削除されたり、より良い機能に置き換えられたりすることがあります。 このプロセスに関する詳細は、Kubernetes非推奨ポリシーを参照してください。 これらの非推奨化や削除の多くは、Kubernetes v1.33の先行紹介ブログで告知されました。

Endpoints APIの非推奨化

v1.21以降GAされたEndpointSlice APIは、元のEndpoint APIを事実上置き換えました。 元のEndpoint APIはシンプルで分かりやすかったものの、多数のネットワークエンドポイントへスケーリングする際にいくつかの課題がありました。 EndpointSlice APIにはデュアルスタックネットワーキングなどの新機能が導入され、これにより元のEndpoint APIは非推奨化されることになりました。

この非推奨化は、ワークロードやスクリプトからEndpoint APIを直接使用しているユーザーにのみ影響します。 これらのユーザーは代わりにEndpointSliceを使用するように移行する必要があります。 非推奨化による影響と移行計画に関する詳細を記載した専用のブログ記事が公開される予定です。

詳細はKEP-4974: Deprecate v1.Endpointsで確認できます。

Nodeステータスにおけるkube-proxyバージョン情報の削除

v1.31の「Deprecation of status.nodeInfo.kubeProxyVersion field for Nodes」で強調されているように、v1.31での非推奨化に続き、Nodeの.status.nodeInfo.kubeProxyVersionフィールドがv1.33で削除されました。

このフィールドはkubeletによって設定されていましたが、その値は一貫して正確ではありませんでした。 v1.31以降デフォルトで無効化されていたため、このフィールドはv1.33で完全に削除されました。

詳細はKEP-4004: Deprecate status.nodeInfo.kubeProxyVersion fieldで確認できます。

インツリーのgitRepoボリュームドライバーの削除

gitRepoボリュームタイプは、約7年前のv1.11から非推奨化されていました。

非推奨化されて以降、gitRepoボリュームタイプがノード上でrootとしてリモートコード実行を得るためにどのように悪用されうるかといった、セキュリティ上の懸念がありました。

v1.33では、インツリーのドライバーコードが削除されます。

代替手段としてgit-syncやinitコンテナがあります。

Kubernetes APIのgitVolumesは削除されないため、gitRepoボリュームを持つPodはkube-apiserverによって受け入れられます。

しかし、フィーチャーゲートのGitRepoVolumeDriverがfalseに設定されているkubeletはそれらを実行せず、ユーザーに適切なエラーを返します。

これにより、ユーザーはワークロードを修正するための十分な時間を確保するために、3バージョン分の期間、ドライバーの再有効化をオプトインできます。

kubeletのフィーチャーゲートとインツリーのプラグインコードは、v1.39リリースで削除される予定です。

詳細はKEP-5040: Remove gitRepo volume driverで確認できます。

Windows Podにおけるホストネットワークサポートの削除

Windows Podのネットワーキングは、コンテナがNodeのネットワーク名前空間を使用できるようにすることでLinuxとの機能パリティを達成し、クラスター密度を向上させることを目指していました。

元の実装はv1.26でアルファとして導入されましたが、予期せぬcontainerdの挙動に直面し、代替ソリューションが存在したため、Kubernetesプロジェクトは関連するKEPを取り下げることを決定しました。

サポートはv1.33で完全に削除されました。

これは、ホストネットワークおよびホストレベルのアクセスを提供するHostProcessコンテナには影響しないことに注意してください。 v1.33で取り下げられたKEPは、ホストネットワークのみを提供することに関するものでしたが、Windowsのネットワーキングロジックにおける技術的な制限のため、安定することはありませんでした。

詳細はKEP-3503: Host network support for Windows podsで確認できます。

リリースノート

Kubernetes v1.33リリースの詳細については、リリースノートをご覧ください。

入手方法

Kubernetes v1.33はGitHubまたはKubernetes公式サイトのダウンロードページからダウンロードできます。

Kubernetesを始めるには、チュートリアルをチェックするか、minikubeを使用してローカルKubernetesクラスターを実行してください。 また、kubeadmを使用して簡単にv1.33をインストールすることもできます。

リリースチーム

Kubernetesはそのコミュニティのサポート、コミットメント、そして懸命な働きによってのみ実現可能です。 リリースチームは、ユーザーが依存するKubernetesリリースを構成する多くの部分を構築するために協力する、献身的なコミュニティボランティアによって構成されています。 これには、コード自体からドキュメンテーションやプロジェクト管理まで、コミュニティのあらゆる分野の人々の専門的なスキルが必要です。

私たちは、Kubernetes v1.33リリースをコミュニティに提供するために熱心に取り組んだ時間について、リリースチーム全体に感謝します。 リリースチームのメンバーは、初めてのShadow(見習い)から、複数のリリースサイクルで培われた経験を持ち、復帰をしたチームリードまで幅広く存在します。 このリリースサイクルでは、リリースノートとDocsのサブチームを統合し、Docsサブチームに統一するという新しいチーム構造が採用されました。 新しいDocsチームから関連情報とリソースを整理する綿密な努力のおかげで、リリースノートとDocsの追跡は円滑かつ成功した移行を実現しました。 最後に、成功したリリースサイクルを通してのサポート、支援、誰もが効果的に貢献できるようにする取り組み、そしてリリースプロセスを改善するための課題に対して、リリースリードのNina Polshakovaに心より感謝します。

プロジェクトの活動状況

CNCF K8sのDevStatsプロジェクトは、Kubernetesおよび様々なサブプロジェクトの活動状況に関する興味深いデータポイントを集計しています。 これには個人の貢献から貢献企業数まで含まれ、このエコシステムの発展に費やされる努力の深さと広さを示しています。

v1.33リリースサイクル(2025年1月13日から4月23日までの15週間)において、Kubernetesには最大121の異なる企業と570人の個人から貢献がありました(執筆時点では、リリース日の数週間前の数値です)。 より広範なクラウドネイティブエコシステムでは、この数字は435社、合計2400人のコントリビューターに達しています。 データソースはこのダッシュボードで確認できます。 前回のリリースv1.32の活動データと比較すると、企業や個人からの貢献レベルは同様であり、コミュニティの関心と参加が引き続き強いことを示しています。

なお、「貢献」とはコミットの作成、コードレビュー、コメント、IssueやPRの作成、PRのレビュー(ブログやドキュメントを含む)、またはIssueやPRへのコメントを行うことを指します。 貢献に興味がある場合は、公式ドキュメントのコントリビューター向けのはじめにをご覧ください。

Kubernetesプロジェクトとコミュニティの全体的な活動状況についてさらに詳しく知るには、DevStatsをチェックしてください。

イベント情報

今後開催予定のKubernetesおよびクラウドネイティブイベント(KubeCon + CloudNativeCon、KCDなど)や、世界各地で開催される主要なカンファレンスについて紹介します。 Kubernetesコミュニティの最新情報を入手し、参加しましょう!

2025年5月

- KCD - Kubernetes Community Days: Costa Rica: 2025年5月3日 | コスタリカ、エレディア

- KCD - Kubernetes Community Days: Helsinki: 2025年5月6日 | フィンランド、ヘルシンキ

- KCD - Kubernetes Community Days: Texas Austin: 2025年5月15日 | アメリカ、オースティン

- KCD - Kubernetes Community Days: Seoul: 2025年5月22日 | 韓国、ソウル

- KCD - Kubernetes Community Days: Istanbul, Turkey: 2025年5月23日 | トルコ、イスタンブール

- KCD - Kubernetes Community Days: San Francisco Bay Area: 2025年5月28日 | アメリカ、サンフランシスコ

2025年6月

- KCD - Kubernetes Community Days: New York: 2025年6月4日 | アメリカ、ニューヨーク

- KCD - Kubernetes Community Days: Czech & Slovak: 2025年6月5日 | スロバキア、ブラチスラバ

- KCD - Kubernetes Community Days: Bengaluru: 2025年6月6日 | インド、バンガロール

- KubeCon + CloudNativeCon China 2025: 2025年6月10日-11日 | 香港

- KCD - Kubernetes Community Days: Antigua Guatemala: 2025年6月14日 | グアテマラ、アンティグア・グアテマラ

- KubeCon + CloudNativeCon Japan 2025: 2025年6月16日-17日 | 日本、東京

- KCD - Kubernetes Community Days: Nigeria, Africa: 2025年6月19日 | アフリカ、ナイジェリア

2025年7月

- KCD - Kubernetes Community Days: Utrecht: 2025年7月4日 | オランダ、ユトレヒト

- KCD - Kubernetes Community Days: Taipei: 2025年7月5日 | 台湾、台北

- KCD - Kubernetes Community Days: Lima, Peru: 2025年7月19日 | ペルー、リマ

2025年8月

- KubeCon + CloudNativeCon India 2025: 2025年8月6日-7日 | インド、ハイデラバード

- KCD - Kubernetes Community Days: Colombia: 2025年8月29日 | コロンビア、ボゴタ

最新のKCD情報はこちらでご確認いただけます。

ウェビナーのご案内

Kubernetes v1.33リリースチームのメンバーと一緒に 2025年5月16日(金)午後4時(UTC) から、このリリースのハイライトやアップグレードの計画に役立つ非推奨事項や削除事項について学びましょう。 詳細および参加登録は、CNCFオンラインプログラム・サイトのイベントページをご覧ください。

参加方法

Kubernetesに関わる最も簡単な方法は、あなたの興味に合ったSpecial Interest Groups (SIGs)のいずれかに参加することです。 Kubernetesコミュニティに向けて何か発信したいことはありますか? 毎週のコミュニティミーティングや、以下のチャンネルであなたの声を共有してください。 継続的なフィードバックとサポートに感謝いたします。

- 最新情報はBlueSkyの@kubernetes.ioをフォローしてください

- Discussでコミュニティディスカッションに参加してください

- Slackでコミュニティに参加してください

- Server FaultかStack Overflowで質問したり、回答したりしてください

- あなたのKubernetesに関するストーリーを共有してください

- Kubernetesの最新情報はブログでさらに詳しく読むことができます

- Kubernetes Release Teamについての詳細はこちらをご覧ください

kube-scheduler-simulatorの紹介

Kubernetesスケジューラーは、Podがどのノードで実行されるかを決定する、非常に重要なコントロールプレーンコンポーネントです。 そのため、Kubernetesを利用するすべてのユーザーは、スケジューラーに依存しています。

kube-scheduler-simulatorは、Kubernetesスケジューラーの シミュレーター であり、Google Summer of Code 2021において私(Kensei Nakada)が開発を開始し、その後多くのコントリビューションを受けてきたプロジェクトです。 このツールを使用すると、スケジューラーの動作や意思決定を詳細に観察することができます。

このシミュレーターは、スケジューリング制約(たとえば、Pod間のアフィニティ)を利用する一般ユーザーにとっても有用ですし、カスタムプラグインによってスケジューラーを拡張するエキスパートにとっても有用です。

動機

スケジューラーは、多くのプラグインで構成されており、それぞれが独自の観点でスケジューリングの意思決定に寄与しているため、しばしばブラックボックスのように見えます。 その動作を理解することは、考慮される要素が非常に多いため困難です。

たとえシンプルなテストクラスターにおいてPodが正しくスケジューリングされているように見えても、想定とは異なる計算に基づいてスケジューリングされている可能性があります。 このようなずれは、本番の大規模な環境において、予期しないスケジューリング結果を引き起こすことにつながりかねません。

また、スケジューラーをテストすることは非常に複雑な課題です。 実際のクラスター内では無数の操作パターンが存在し、有限な数のテストであらゆるシナリオを予測することは現実的ではありません。 多くの場合、スケジューラーを実際のクラスターにデプロイして初めてバグが発見されます。 実際、アップストリームのkube-schedulerであっても、リリース後にユーザーによって多くのバグが発見されています。

スケジューラー、あるいはどんなKubernetesコントローラーであっても、それらをテストするための開発環境やサンドボックス環境を用意することは、一般的なプラクティスです。 しかし、この方法では、本番クラスターで発生し得るすべてのシナリオを網羅するには不十分です。 というのも、開発クラスターは通常、本番に比べてはるかに小規模であり、ワークロードの規模やスケーリングの特性にも大きな違いがあるためです。 開発クラスターは本番環境とまったく同じ使われ方をすることはなく、同じ挙動を示すこともありません。

kube-scheduler-simulatorは、これらの問題を解決することを目的としています。 ユーザーは、このツールを用いてスケジューリング制約やスケジューラーの設定、カスタムプラグインをテストしつつ、スケジューリングの意思決定におけるあらゆる詳細な部分を確認することができます。 また、ユーザーは本番クラスターと同じリソースを使いながら、実際のワークロードに影響を与えることなく、スケジューラーをテストできるシミュレートされたクラスター環境を作成することも可能です。

kube-scheduler-simulatorの機能

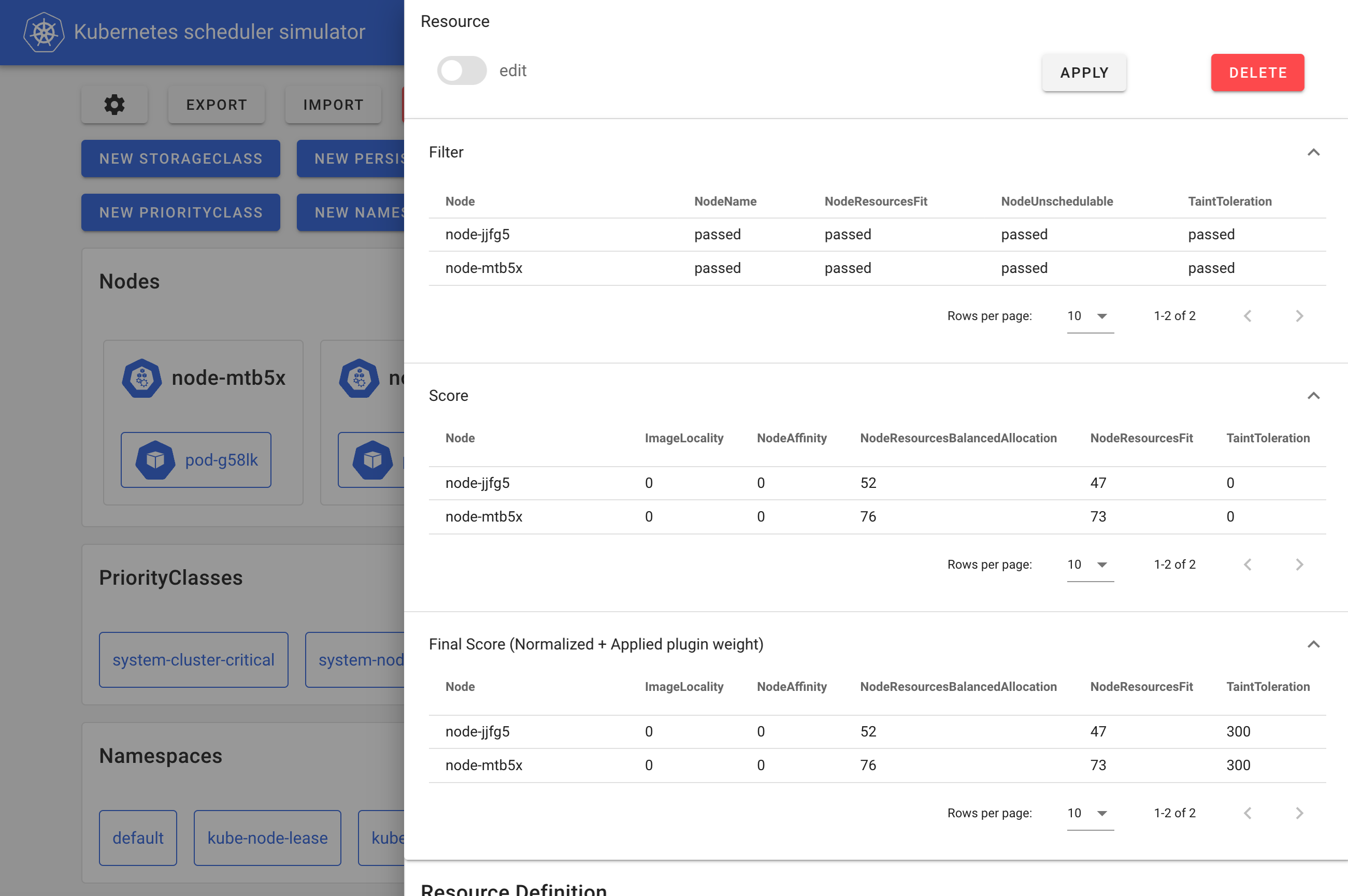

kube-scheduler-simulatorのコア機能は、スケジューラーの内部的な意思決定を可視化できる点にあります。 スケジューラーはスケジューリングフレームワークに基づいて動作しており、さまざまな拡張ポイントで複数のプラグインを利用し、ノードのフィルタリング(Filterフェーズ)、スコア付け(Scoreフェーズ)を経て、最終的にPodに最適なノードを決定します。

このシミュレーターを用いることで、ユーザーはKubernetesリソースを作成し、各プラグインがPodのスケジューリングにどのように影響を与えているかを観察できます。 これにより、スケジューラーの仕組みを理解し、適切なスケジューリング制約を定義する助けとなります。

シミュレーターのwebフロントエンド

このシミュレーターの内部では、通常のスケジューラー(vanilla scheduler)ではなく、Debuggable Schedulerと呼ばれるデバッグを容易にするスケジューラーが動作します。 このDebuggable Schedulerは、各拡張ポイントにおける各スケジューラープラグインの結果を、以下のマニフェストに示すようにPodのアノテーションとして出力します。 webフロントエンドはこれらのアノテーションに基づいてスケジューリング結果を整形・可視化します。

kind: Pod

apiVersion: v1

metadata:

# このブログ投稿では、アノテーション内のJSONは見やすさのために手動で整形されています。

annotations:

kube-scheduler-simulator.sigs.k8s.io/bind-result: '{"DefaultBinder":"success"}'

kube-scheduler-simulator.sigs.k8s.io/filter-result: >-

{

"node-jjfg5":{

"NodeName":"passed",

"NodeResourcesFit":"passed",

"NodeUnschedulable":"passed",

"TaintToleration":"passed"

},

"node-mtb5x":{

"NodeName":"passed",

"NodeResourcesFit":"passed",

"NodeUnschedulable":"passed",

"TaintToleration":"passed"

}

}

kube-scheduler-simulator.sigs.k8s.io/finalscore-result: >-

{

"node-jjfg5":{

"ImageLocality":"0",

"NodeAffinity":"0",

"NodeResourcesBalancedAllocation":"52",

"NodeResourcesFit":"47",

"TaintToleration":"300",

"VolumeBinding":"0"

},

"node-mtb5x":{

"ImageLocality":"0",

"NodeAffinity":"0",

"NodeResourcesBalancedAllocation":"76",

"NodeResourcesFit":"73",

"TaintToleration":"300",

"VolumeBinding":"0"

}

}

kube-scheduler-simulator.sigs.k8s.io/permit-result: '{}'

kube-scheduler-simulator.sigs.k8s.io/permit-result-timeout: '{}'

kube-scheduler-simulator.sigs.k8s.io/postfilter-result: '{}'

kube-scheduler-simulator.sigs.k8s.io/prebind-result: '{"VolumeBinding":"success"}'

kube-scheduler-simulator.sigs.k8s.io/prefilter-result: '{}'

kube-scheduler-simulator.sigs.k8s.io/prefilter-result-status: >-

{

"AzureDiskLimits":"",

"EBSLimits":"",

"GCEPDLimits":"",

"InterPodAffinity":"",

"NodeAffinity":"",

"NodePorts":"",

"NodeResourcesFit":"success",

"NodeVolumeLimits":"",

"PodTopologySpread":"",

"VolumeBinding":"",

"VolumeRestrictions":"",

"VolumeZone":""

}

kube-scheduler-simulator.sigs.k8s.io/prescore-result: >-

{

"InterPodAffinity":"",

"NodeAffinity":"success",

"NodeResourcesBalancedAllocation":"success",

"NodeResourcesFit":"success",

"PodTopologySpread":"",

"TaintToleration":"success"

}

kube-scheduler-simulator.sigs.k8s.io/reserve-result: '{"VolumeBinding":"success"}'

kube-scheduler-simulator.sigs.k8s.io/result-history: >-

[

{

"kube-scheduler-simulator.sigs.k8s.io/bind-result":"{\"DefaultBinder\":\"success\"}",

"kube-scheduler-simulator.sigs.k8s.io/filter-result":"{\"node-jjfg5\":{\"NodeName\":\"passed\",\"NodeResourcesFit\":\"passed\",\"NodeUnschedulable\":\"passed\",\"TaintToleration\":\"passed\"},\"node-mtb5x\":{\"NodeName\":\"passed\",\"NodeResourcesFit\":\"passed\",\"NodeUnschedulable\":\"passed\",\"TaintToleration\":\"passed\"}}",

"kube-scheduler-simulator.sigs.k8s.io/finalscore-result":"{\"node-jjfg5\":{\"ImageLocality\":\"0\",\"NodeAffinity\":\"0\",\"NodeResourcesBalancedAllocation\":\"52\",\"NodeResourcesFit\":\"47\",\"TaintToleration\":\"300\",\"VolumeBinding\":\"0\"},\"node-mtb5x\":{\"ImageLocality\":\"0\",\"NodeAffinity\":\"0\",\"NodeResourcesBalancedAllocation\":\"76\",\"NodeResourcesFit\":\"73\",\"TaintToleration\":\"300\",\"VolumeBinding\":\"0\"}}",

"kube-scheduler-simulator.sigs.k8s.io/permit-result":"{}",

"kube-scheduler-simulator.sigs.k8s.io/permit-result-timeout":"{}",

"kube-scheduler-simulator.sigs.k8s.io/postfilter-result":"{}",

"kube-scheduler-simulator.sigs.k8s.io/prebind-result":"{\"VolumeBinding\":\"success\"}",

"kube-scheduler-simulator.sigs.k8s.io/prefilter-result":"{}",

"kube-scheduler-simulator.sigs.k8s.io/prefilter-result-status":"{\"AzureDiskLimits\":\"\",\"EBSLimits\":\"\",\"GCEPDLimits\":\"\",\"InterPodAffinity\":\"\",\"NodeAffinity\":\"\",\"NodePorts\":\"\",\"NodeResourcesFit\":\"success\",\"NodeVolumeLimits\":\"\",\"PodTopologySpread\":\"\",\"VolumeBinding\":\"\",\"VolumeRestrictions\":\"\",\"VolumeZone\":\"\"}",

"kube-scheduler-simulator.sigs.k8s.io/prescore-result":"{\"InterPodAffinity\":\"\",\"NodeAffinity\":\"success\",\"NodeResourcesBalancedAllocation\":\"success\",\"NodeResourcesFit\":\"success\",\"PodTopologySpread\":\"\",\"TaintToleration\":\"success\"}",

"kube-scheduler-simulator.sigs.k8s.io/reserve-result":"{\"VolumeBinding\":\"success\"}",

"kube-scheduler-simulator.sigs.k8s.io/score-result":"{\"node-jjfg5\":{\"ImageLocality\":\"0\",\"NodeAffinity\":\"0\",\"NodeResourcesBalancedAllocation\":\"52\",\"NodeResourcesFit\":\"47\",\"TaintToleration\":\"0\",\"VolumeBinding\":\"0\"},\"node-mtb5x\":{\"ImageLocality\":\"0\",\"NodeAffinity\":\"0\",\"NodeResourcesBalancedAllocation\":\"76\",\"NodeResourcesFit\":\"73\",\"TaintToleration\":\"0\",\"VolumeBinding\":\"0\"}}",

"kube-scheduler-simulator.sigs.k8s.io/selected-node":"node-mtb5x"

}

]

kube-scheduler-simulator.sigs.k8s.io/score-result: >-

{

"node-jjfg5":{

"ImageLocality":"0",

"NodeAffinity":"0",

"NodeResourcesBalancedAllocation":"52",

"NodeResourcesFit":"47",

"TaintToleration":"0",

"VolumeBinding":"0"

},

"node-mtb5x":{

"ImageLocality":"0",

"NodeAffinity":"0",

"NodeResourcesBalancedAllocation":"76",

"NodeResourcesFit":"73",

"TaintToleration":"0",

"VolumeBinding":"0"

}

}

kube-scheduler-simulator.sigs.k8s.io/selected-node: node-mtb5x

ユーザーはまた、自身のカスタムプラグインやextenderをこのDebuggable Schedulerに統合し、その結果を可視化することもできます。

このDebuggable Schedulerは、たとえば任意のKubernetesクラスター上や統合テスト内など、スタンドアローンで実行することも可能です。これは、自身のプラグインをテストしたり、実クラスター上でカスタムスケジューラーをよりデバッグしやすくしたいと考えるカスタムプラグイン開発者にとって有用です。

より優れた開発クラスターとしてのシミュレーター

前述のとおり、限られたテストだけでは実世界のクラスターで起こり得るすべてのシナリオを予測することは不可能です。 ユーザーはスケジューラーを本番環境にデプロイする前に、小規模な開発クラスターでテストし、問題が発生しないことを願うことしかできません。

そこで、シミュレーターのインポート機能を使うことで、本番環境に近い環境で、稼働中のワークロードに影響を与えることなくスケジューラーのシミュレーションをすることができます。

本番クラスターとシミュレーターの間で継続的に同期を行うことで、ユーザーは本番クラスターが対応するリソースと同じリソースを用いて、新しいバージョンのスケジューラーを安全にテストすることができます。 その動作に確信が持てた段階で本番環境へのデプロイに進むことができ、予期しない問題のリスクを低減できます。

ユースケースは?

- クラスターユーザー: スケジューリング制約(たとえば、PodAffinityやPodTopologySpreadなど)が意図した通りに機能しているかを検証する。

- クラスター管理者: スケジューラーの設定を変更した場合に、クラスターがどのように動作するかを評価する。

- スケジューラープラグイン開発者: カスタムスケジューラープラグインやスケジューラー拡張をテストする。Debuggable Schedulerを統合テストや開発クラスターで使用したり、本番環境に近い環境でのテストのために同期機能を活用したりする。

利用開始の手順

このシミュレーターを使用するには、マシンにDockerがインストールされていれば十分で、Kubernetesクラスターは必要ありません。

git clone git@github.com:kubernetes-sigs/kube-scheduler-simulator.git

cd kube-scheduler-simulator

make docker_up

http://localhost:3000でシミュレーターのweb UIにアクセスできます。

詳しくは、kube-scheduler-simulatorのリポジトリをご覧ください!

貢献するには

このシミュレーターは、Kubernetes SIG Schedulingによって開発されています。 フィードバックやコントリビューションは大歓迎です!

問題の報告やプルリクエストは、kube-scheduler-simulatorのリポジトリで行ってください。 また、Slackの#sig-schedulingチャンネルにもぜひご参加ください。

謝辞

このシミュレーターのプロジェクトは、熱意あるボランティアのエンジニアたちによってメンテナンスされ、多くの課題を乗り越えて現在の形に至りました。

素晴らしいコントリビューターの皆さんに心より感謝いたします!

Kubernetes v1.33の先行紹介

Kubernetes v1.33のリリースが近づく中で、Kubernetesプロジェクトは進化を続けています。 プロジェクト全体の健全性を高めるために、一部の機能が非推奨となったり、削除または置き換えられたりする可能性があります。 本ブログ記事では、v1.33リリースに向けて計画されている変更の一部を紹介します。 これらは、Kubernetes環境を安定して運用し、最新の開発動向を把握し続けるために、リリースチームが特に知っておくべきであると考えている情報です。 以下の情報は、v1.33リリースの現時点の状況に基づいており、正式リリースまでに変更される可能性があります。

Kubernetes APIの削除および非推奨プロセス

Kubernetesプロジェクトでは、機能の非推奨ポリシーが明確に文書化されています。 このポリシーでは、安定版のAPIを非推奨とするには同じAPIの新たな安定版が存在していることが条件とされています。 また、APIの安定性レベルごとに最低限のサポート期間が定められています。 非推奨となったAPIは、将来のKubernetesリリースで削除される予定であることを示しています。 削除までは引き続き動作しますが(非推奨から少なくとも1年間は利用可能です)、利用時には警告メッセージが表示されます。 削除されたAPIは現在のバージョンでは利用できなくなり、その時点で代替手段への移行が必須となります。

-

一般公開版(GA)または安定版のAPIバージョンが非推奨となる可能性はありますが、Kubernetesの同一のメジャーバージョン内で削除されてはなりません。

-

ベータ版やプレリリースのAPIバージョンは、非推奨となってから3つのリリース分はサポートされなければなりません。

-

アルファ版または実験的なAPIバージョンは、事前の非推奨通知なしに任意のリリースで削除される可能性があります。すでに同一の機能に対して別の実装が存在する場合、このプロセスは「撤回」と見なされることがあります。

機能がベータ版から安定版へ昇格した結果としてAPIが削除される場合でも、単にそのAPIが定着しなかった場合でも、すべての削除はこの非推奨ポリシーに準拠して実施されます。 APIが削除される際には、移行手段が非推奨ガイド内で案内されます。

Kubernetes v1.33における非推奨と削除

安定版Endpoints APIの非推奨化

EndpointSlices APIはv1.21から安定版となっており、実質的に従来のEndpoints APIを置き換える存在となっています。 元のEndpoints APIはシンプルで分かりやすい設計でしたが、大規模なネットワークエンドポイントにスケールする際に課題がありました。 EndpointSlices APIはデュアルスタックネットワーク対応などの新機能を導入しており、これにより従来のEndpoints APIは非推奨とする準備が整いました。

今回の非推奨は、ワークロードやスクリプトからEndpoints APIを直接使用しているユーザーのみに影響します。 これらのユーザーは、代わりにEndpointSliceの使用へ移行する必要があります。 非推奨による影響と移行計画の詳細については、今後数週間以内に専用のブログ記事が公開される予定です。

詳細はKEP-4974: Deprecate v1.Endpointsをご覧ください。

ノードステータスからのkube-proxyバージョン情報の削除

リリースアナウンスで示されたとおり、v1.31で非推奨となったstatus.nodeInfo.kubeProxyVersionフィールドは、v1.33で削除されます。

このフィールドはkubeletによって設定されていましたが、その値は一貫して正確とは限りませんでした。

v1.31以降、このフィールドはデフォルトで無効化されているため、v1.33では完全に削除されます。

詳細はKEP-4004: Deprecate status.nodeInfo.kubeProxyVersion fieldをご覧ください。

Windows Podにおけるホストネットワーク対応の削除

Windows Podのネットワーク機能は、Linuxと同等の機能を提供し、コンテナがノードのネットワーク名前空間を使用できるようにすることで、クラスター密度の向上を目指していました。 この機能の初期実装はv1.26でアルファ版として導入されましたが、containerdに関する予期せぬ挙動が確認され、また代替手段も存在していたことから、Kubernetesプロジェクトは関連するKEPの撤回を決定しました。 v1.33において、この機能のサポートは完全に削除される見込みです。

詳細はKEP-3503: Host network support for Windows podsをご覧ください。

Kubernetes v1.33の注目すべき変更点

本記事の執筆者として、私たちは特に注目すべき重要な改善点を1つ選びました!

Linux Podにおけるユーザー名前空間のサポート

現在もオープンなKEPの中で最も古いものの一つが、KEP-127「Podに対してLinuxユーザー名前空間を使用することによるセキュリティの改善」です。このKEPは2016年後半に初めて提案され、複数回の改訂を経てv1.25でアルファ版として登場し、v1.30で初めてベータ版が提供されました(この時点ではデフォルトで無効)。そしてv1.33では、この機能がデフォルトで有効な状態で提供される予定です。

この機能は、明示的にpod.spec.hostUsersを指定して有効化しない限り、既存のPodには影響しません。

Kubernetes v1.30をそっと覗くでも触れられているように、この機能は脆弱性の軽減に向けた重要なマイルストーンとなります。

詳細はKEP-127: Support User Namespaces in podsをご覧ください。

その他の注目すべきKubernetes v1.33の改善点

以下に挙げる改善項目は、今後リリース予定のv1.33に含まれる見込みのものです。 ただし、これらは確定事項ではなく、リリース内容は変更される可能性があります。

Podの垂直スケーリングに対応したリソースの動的リサイズ

Podをプロビジョニングする際には、DeploymentやStatefulSetなど、さまざまなリソースを利用できます。

スケーラビリティの要件によっては、Podのレプリカ数を更新する水平スケーリング、あるいはPod内のコンテナに割り当てるリソースを更新する垂直スケーリングが必要になる場合があります。

この改善が導入される以前は、Podのspecに定義されたコンテナリソースは変更できず、Podテンプレート内のリソースを更新するとPodの置き換えが発生していました。

しかし、既存のPodを再起動せずに、動的にリソース設定を更新できたらどうでしょうか?

KEP-1287は、まさにこのようなPodのインプレース更新を可能にするためのものです。 これにより、ステートフルなプロセスに対してダウンタイムなしでの垂直スケールアップや、トラフィックが少ないときのシームレスなスケールダウン、さらには起動時に一時的に大きなリソースを割り当て、初期処理が完了した後にそれを縮小するといったことも可能になります。 この機能はv1.27でアルファ版としてリリースされており、v1.33ではベータ版として提供される予定です。

詳細はKEP-1287: In-Place Update of Pod Resourcesをご覧ください。

DRAのResourceClaimにおけるデバイスステータスがベータに昇格

ResourceClaimのstatus内にあるdevicesフィールドは、v1.32リリースで導入された機能であり、v1.33でベータに昇格する見込みです。

このフィールドは、ドライバーがデバイスの状態情報を報告できるようにするもので、可観測性とトラブルシューティング能力の向上に貢献します。

例えば、ResourceClaimのステータスにネットワークインターフェースの名前、MACアドレス、IPアドレスを報告することは、ネットワークサービスの設定や管理、ならびにネットワーク関連の問題のデバッグに大いに役立ちます。この機能の詳細は、動的リソース割り当てのドキュメントをご覧ください。

また、計画中の拡張についてはKEP-4817: DRA: Resource Claim Status with possible standardized network interface dataに記載されています。

名前空間の順序付き削除

このKEPは、Kubernetesの名前空間に対して、より構造化された削除プロセスを導入することで、リソースの安全かつ決定論的な削除を実現することを目的としています。 現在の削除処理はほぼランダムな順序で行われるため、たとえばNetworkPolicyが先に削除されてPodが残るといった、セキュリティ上の問題や意図しない動作を引き起こす可能性があります。 論理的およびセキュリティ上の依存関係を考慮した構造化された削除順序を強制することで、このアプローチはPodが他のリソースより先に削除されることを保証します。 この設計は、非決定的な削除に関連するリスクを軽減することで、Kubernetesのセキュリティと信頼性を向上させます。

詳細はKEP-5080: Ordered namespace deletionをご覧ください。

Indexed Job管理の強化

これら2つのKEPは、ジョブの処理、特にIndexed Jobの信頼性を向上させるためにGAに昇格する予定です。 KEP-3850では、Indexed Jobに対してインデックスごとのバックオフ制限を提供しており、各インデックスが他のインデックスと完全に独立して動作できるようになります。 また、KEP-3998はJob APIを拡張し、すべてのインデックスが成功していない場合でもIndexed Jobを成功と見なすための条件を定義できるようにします。

詳細は、KEP-3850: Backoff Limit Per Index For Indexed JobsおよびKEP-3998: Job success/completion policyをご覧ください。

さらに詳しく知りたい方へ

新機能や非推奨の項目については、Kubernetesのリリースノートでもアナウンスされています。 Kubernetes v1.33の新機能については、該当リリースのCHANGELOGにて正式に発表される予定です。

Kubernetes v1.33のリリースは 2025年4月23日(水) を予定しています。 今後の更新情報にもぜひご注目ください!

以下のリリースノートでも、各バージョンにおける変更点のアナウンスを確認できます。

コミュニティへの参加方法

Kubernetesに関わるための最も簡単な方法は、関心のある分野に関連するSpecial Interest Groups(SIGs)のいずれかに参加することです。 Kubernetesコミュニティに向けて発信したい内容がありますか? もしあれば、毎週開催されているコミュニティミーティングや、下記の各種チャネルを通じて、ぜひ声を届けてください。 皆さまからの継続的なご意見とご支援に、心より感謝申し上げます。

- 最新情報はBlueskyの@kubernetes.ioでご確認ください

- Discussでコミュニティのディスカッションに参加しましょう

- Slackのコミュニティに参加しましょう

- Server FaultやStack Overflowに質問を投稿したり、他の質問に回答したりしましょう

- あなたのKubernetesストーリーを共有しましょう

- Kubernetesに関する最新情報はブログをご覧ください

- Kubernetesリリースチームについて学びましょう

Kubernetes v1.32: Penelope

編集者: Matteo Bianchi, Edith Puclla, William Rizzo, Ryota Sawada, Rashan Smith

Kubernetes v1.32: Penelopeのリリースを発表します!

これまでのリリースと同様に、Kubernetes v1.32では新たなGA、ベータ、アルファの機能が導入されています。 継続的に高品質なリリースを提供できていることは、私たちの開発サイクルの強さと、活発なコミュニティのサポートを示すものです。 今回のリリースでは、44の機能強化が行われました。 そのうち、13の機能がGAに昇格し、12の機能がベータに移行し、19の機能がアルファとして導入されています。

リリースのテーマとロゴ

Kubernetes v1.32のリリーステーマは"Penelope"です。

Kubernetesが古代ギリシャ語で「パイロット」または「舵取り」を意味することから始め、このリリースではKubernetesの10年間とその成果を振り返ります。 各リリースサイクルは一つの旅路であり、「オデュッセイア」のペーネロペーが10年の間、昼に織ったものを夜になると解いていったように、各リリースでは新機能の追加と既存機能の削除を行います。 ただしここでは、Kubernetesを継続的に改善するというより明確な目的を持って行われています。 v1.32はKubernetesが10周年を迎える年の最後のリリースとなることから、クラウドネイティブの海の試練や課題を航海してきたグローバルなKubernetesクルーの一員として貢献してくださった全ての方々に敬意を表したいと思います。 これからも共にKubernetesの未来を紡いでいけることを願っています。

最近の主要な機能の更新

DRAの機能強化に関する注記

今回のリリースでは、前回のリリースと同様に、KubernetesプロジェクトはDynamic Resource Allocation(DRA)に対して多くの機能強化を提案し続けています。 DRAはKubernetesのリソース管理システムの主要なコンポーネントです。 これらの機能強化は、GPU、FPGA、ネットワークアダプターなどの特殊なハードウェアを必要とするワークロードに対するリソース割り当ての柔軟性と効率性を向上させることを目的としています。

これらの機能は、機械学習や高性能コンピューティングアプリケーションなどのユースケースで特に有用です。DRAのStructured parameterサポートを可能にするコア部分はベータに昇格しました。

ノードとサイドカーコンテナの更新における振る舞いの改善

SIG Nodeでは、KEPの範囲を超えて以下のような改善が行われています:

-

kubeletのヘルスチェックが失敗した際にkubeletを再起動するために、systemdのwatchdog機能が使用されるようになりました。 また、一定時間内の最大再起動回数も制限されます。 これによりkubeletの信頼性が向上します。 詳細についてはPull Requestの#127566をご覧ください。

-

イメージプルのバックオフエラーが発生した場合、Podのステータスに表示されるメッセージが改善され、より分かりやすくなり、Podがこの状態にある理由の詳細が示されるようになりました。 イメージプルのバックオフが発生すると、エラーはPod仕様の

status.containerStatuses[*].state.waiting.messageフィールドに追加され、reasonフィールドにはImagePullBackOffの値が設定されます。 この変更により、より多くのコンテキストが提供され、問題の根本原因を特定するのに役立ちます。 詳細については、Pull Requestの#127918をご覧ください。 -

サイドカーコンテナ機能は、v1.33でStableへの昇格を目指しています。 残りの作業項目とユーザーからのフィードバックについては、Issueの#753のコメントをご覧ください。

GAに昇格した機能のハイライト

これは、v1.32のリリースに伴いGAとなった改善点の一部です。

カスタムリソースのフィールドセレクター

カスタムリソースのフィールドセレクターにより、開発者は組み込みのKubernetesオブジェクトで利用できる機能と同様に、カスタムリソースにフィールドセレクターを追加できるようになりました。 これにより、カスタムリソースのより効率的で正確なフィルタリングが可能になり、より良いAPI設計の実践を促進します。

この作業は、SIG API MachineryによりKEP #4358の一部として実施されました。

SizeMemoryBackedVolumesのサポート

この機能により、Podのリソース制限に基づいてメモリバックアップボリュームを動的にサイズ設定できるようになり、ワークロードの移植性とノードのリソース使用率の全体的な向上を実現します。

この作業は、SIG NodeによりKEP #1967の一部として実施されました。

バインドされたサービスアカウントトークンの改善

サービスアカウントトークンのクレームにノード名を含めることで、認可と認証(ValidatingAdmissionPolicy)の過程でこの情報を使用できるようになりました。 さらに、この改善によりサービスアカウントの認証情報がノードの権限昇格パスとなることを防ぎます。

この作業は、SIG AuthによりKEP #4193の一部として実施されました。

構造化された認可設定

APIサーバーに複数の認可機能を設定できるようになり、webhookでのCELマッチ条件をサポートすることで、構造化された認可の判断が可能になりました。

この作業は、SIG AuthによりKEP #3221の一部として実施されました。

StatefulSetによって作成されたPVCの自動削除

StatefulSetが作成したPersistentVolumeClaim(PVC)は、不要になると自動的に削除されるようになりました。 これはStatefulSetの更新やノードのメンテナンス時にもデータを確実に保持したまま削除処理を行います。 この機能により、StatefulSetのストレージ管理が容易になり、PVCが残されたままになるリスクも減少します。

この作業は、SIG AppsによりKEP #1847の一部として実施されました。

ベータに昇格した機能のハイライト

これは、v1.32のリリースに伴いベータとなった改善点の一部です。

JobのAPI管理メカニズム

JobのmanagedByフィールドがv1.32でベータに昇格しました。

この機能により、外部コントローラー(Kueueなど)がJobの同期を管理できるようになり、高度なワークロード管理システムとのより柔軟な統合が可能になります。

この作業は、SIG AppsによりKEP #4368の一部として実施されました。

設定されたエンドポイントのみの匿名認証を許可

この機能により、管理者は匿名リクエストを許可するエンドポイントを指定できるようになりました。

例えば、管理者は/healthz、/livez、/readyzなどのヘルスエンドポイントへの匿名アクセスのみを許可し、ユーザーがRBACを誤設定した場合でも、他のクラスターエンドポイントやリソースへの匿名アクセスを確実に防止できます。

この作業は、SIG AuthによりKEP #4633の一部として実施されました。

kube-schedulerにおけるプラグインごとの再スケジュール判断機能の改善

この機能は、プラグインごとのコールバック関数(QueueingHint)によってスケジューリングの再試行の判断をより効率的にすることで、スケジューリングのスループットを向上させます。 すべてのプラグインがQueueingHintsを持つようになりました。

この作業は、SIG SchedulingによりKEP #4247の一部として実施されました。

ボリューム拡張の失敗からのリカバリー

この機能により、ユーザーは小さいサイズで再試行することでボリューム拡張の失敗から回復できるようになりました。 この改善により、ボリューム拡張がより堅牢で信頼性の高いものとなり、プロセス中のデータ損失や破損のリスクが軽減されます。

この作業は、SIG StorageによりKEP #1790の一部として実施されました。

ボリュームグループスナップショット

この機能は、VolumeGroupSnapshot APIを導入し、ユーザーが複数のボリュームを同時にスナップショット取得できるようにすることで、ボリューム間のデータ整合性を確保します。

この作業は、SIG StorageによりKEP #3476の一部として実施されました。

構造化パラメーターのサポート

Dynamic Resource Allocation(DRA)のコア部分である構造化パラメーターのサポートがベータに昇格しました。 これにより、kube-schedulerとCluster Autoscalerはサードパーティドライバーを必要とせずに、直接クレームの割り当てをシミュレーションできるようになりました。

これらのコンポーネントは、実際に割り当てを確定することなく、クラスターの現在の状態に基づいてリソース要求が満たされるかどうかを予測できるようになりました。 サードパーティドライバーによる割り当ての検証やテストが不要になったことで、この機能はリソース分配の計画と意思決定を改善し、スケジューリングとスケーリングのプロセスをより効率的にします。

この作業は、WG Device Management(SIG Node、SIG Scheduling、SIG Autoscalingを含む機能横断チーム)によりKEP #4381の一部として実施されました。

ラベルとフィールドセレクターの認可

認可の判断にラベルとフィールドセレクターを使用できるようになりました。 ノードの認可機能は、これを自動的に活用してノードが自身のPodのみをリストやウォッチできるように制限します。 Webhookの認可機能は、使用されるラベルやフィールドセレクターに基づいてリクエストを制限するように更新できます。

この作業は、SIG AuthによりKEP #4601の一部として実施されました。

アルファとして導入された新機能

これは、v1.32のリリースでアルファとして導入された主な改善点の一部です。

Kubernetesスケジューラーにおける非同期プリエンプション

Kubernetesスケジューラーは、プリエンプション操作を非同期で処理することでスケジューリングのスループットを向上させる、非同期プリエンプション機能が強化されました。 プリエンプションは、優先度の低いPodを退避させることで、優先度の高いPodに必要なリソースを確保します。 しかし、これまでこのプロセスではPodを削除するためのAPIコールなどの重い操作が必要で、スケジューラーの速度低下を引き起こしていました。 この強化により、そのような処理が並列で実行されるようになり、スケジューラーは他のPodのスケジューリングを遅延なく継続できるようになりました。 この改善は、特にPodの入れ替わりが頻繁なクラスターや、スケジューリングの失敗が頻発するクラスターで有効で、より効率的で堅牢なスケジューリングプロセスを実現します。

この作業は、SIG SchedulingによりKEP #4832の一部として実施されました。

CEL式を使用したMutating Admission Policy

この機能は、CELのオブジェクトインスタンス化とJSONパッチ戦略を、Server Side Applyのマージアルゴリズムと組み合わせて活用します。 これにより、ポリシー定義が簡素化され、変更の競合が削減され、アドミッション制御のパフォーマンスが向上すると同時に、Kubernetesにおけるより堅牢で拡張可能なポリシーフレームワークの基盤が構築されます。

KubernetesのAPIサーバーは、Common Expression Language(CEL)ベースのMutating Admission Policyをサポートするようになり、Mutating Admission Webhookの軽量で効率的な代替手段を提供します。 この強化により、管理者はCELを使用して、ラベルの設定、フィールドのデフォルト値設定、サイドカーの注入といった変更を、シンプルな宣言的な式で定義できるようになりました。 このアプローチにより、運用の複雑さが軽減され、webhookの必要性が排除され、kube-apiserverと直接統合されることで、より高速で信頼性の高いプロセス内変更処理を実現します。

この作業は、SIG API MachineryによりKEP #3962の一部として実施されました。

Podレベルのリソース指定

この機能強化により、Podレベルでリソースの要求と制限を設定できるようになり、Pod内のすべてのコンテナが動的に使用できる共有プールを作成することで、Kubernetesのリソース管理が簡素化されます。 これは特に、リソース需要が変動的またはバースト的なコンテナを持つワークロードにとって有用で、過剰なプロビジョニングを最小限に抑え、全体的なリソース効率を向上させます。

KubernetesはPodレベルでLinuxのcgroup設定を活用することで、これらのリソース制限を確実に適用しながら、密結合したコンテナが人為的な制約に縛られることなく、より効果的に連携できるようにします。 重要なことに、この機能は既存のコンテナレベルのリソース設定との後方互換性を維持しており、ユーザーは現在のワークフローや既存の設定を中断することなく、段階的に採用できます。

これは、コンテナ間のリソース割り当て管理の運用複雑性を軽減するため、マルチコンテナPodにとって重要な改善となります。 また、コンテナがワークロードを共有したり、最適なパフォーマンスを発揮するために互いの可用性に依存したりするサイドカーアーキテクチャなどの密接に統合されたアプリケーションにおいて、パフォーマンスの向上をもたらします。

この作業は、SIG NodeによりKEP #2837の一部として実施されました。

PreStopフックのスリープアクションでゼロ値を許可

この機能強化により、KubernetesのPreStopライフサイクルフックで0秒のスリープ時間を設定できるようになり、リソースの検証とカスタマイズのためのより柔軟な無操作オプションを提供します。 これまでは、スリープアクションにゼロ値を設定しようとするとバリデーションエラーが発生し、その使用が制限されていました。 この更新により、ユーザーはゼロ秒の時間を有効なスリープ設定として設定でき、必要に応じて即時実行と終了の動作が可能になります。

この機能強化は後方互換性があり、PodLifecycleSleepActionAllowZeroフィーチャーゲートによって制御されるオプトイン機能として導入されています。

この変更は、実際のスリープ時間を必要とせずに、検証やAdmission Webhook処理のためにPreStopフックを必要とするシナリオで特に有効です。

Goのtime.After関数の機能に合わせることで、この更新はKubernetesワークロードの設定を簡素化し、使いやすさを向上させます。

この作業は、SIG NodeによりKEP #4818の一部として実施されました。

DRA:ResourceClaimステータスのための標準化されたネットワークインターフェースデータ

この機能強化により、ドライバーがResourceClaimの各割り当てオブジェクトに対して特定のデバイスステータスデータを報告できる新しいフィールドが追加されました。

また、ネットワークデバイス情報を表現するための標準的な方法も確立されました。

この作業は、SIG NetworkによりKEP #4817の一部として実施されました。

コアコンポーネントの新しいstatuszとflagzエンドポイント

コアコンポーネントに対して、2つの新しいHTTPエンドポイント(/statuszと/flagz)を有効にできるようになりました。

これらのエンドポイントは、コンポーネントが実行されているバージョン(Golangのバージョンなど)や、稼働時間、そのコンポーネントが実行された際のコマンドラインフラグの詳細を把握することで、クラスターのデバッグ性を向上させます。

これにより、実行時および設定の問題の診断が容易になります。

この作業は、SIG InstrumentationによりKEP #4827とKEP #4828の一部として実施されました。

Windowsの逆襲

Kubernetesクラスターにおいて、Windowsノードの正常なシャットダウンのサポートが追加されました。 このリリース以前、KubernetesはLinuxノードに対して正常なノードシャットダウン機能を提供していましたが、Windowsに対する同等のサポートは欠けていました。 この機能強化により、Windowsノード上のkubeletがシステムのシャットダウンイベントを適切に処理できるようになりました。 これにより、Windowsノード上で実行されているPodが正常に終了され、ワークロードの中断なしでの再スケジュールが可能になります。 この改善により、特に計画的なメンテナンスやシステム更新時において、Windowsノードを含むクラスターの信頼性と安定性が向上します。

さらに、CPUマネージャー、メモリマネージャー、トポロジーマネージャーの改善により、Windowsノードに対するCPUとメモリのアフィニティサポートが追加されました。

この作業は、SIG WindowsによりKEP #4802とKEP #4885の一部として実施されました。

1.32における機能の昇格、非推奨化、および削除

GAへの昇格

ここでは、GA(一般提供 とも呼ばれる)に昇格したすべての機能を紹介します。新機能やアルファからベータへの昇格を含む完全な更新リストについては、リリースノートをご覧ください。

このリリースでは、以下の13個の機能強化がGAに昇格しました:

- Structured Authorization Configuration

- Bound service account token improvements

- Custom Resource Field Selectors

- Retry Generate Name

- Make Kubernetes aware of the LoadBalancer behaviour

- Field

status.hostIPsadded for Pod - Custom profile in kubectl debug

- Memory Manager

- Support to size memory backed volumes

- Improved multi-numa alignment in Topology Manager

- Add job creation timestamp to job annotations

- Add Pod Index Label for StatefulSets and Indexed Jobs

- Auto remove PVCs created by StatefulSet

非推奨化と削除

Kubernetesの開発と成熟に伴い、プロジェクト全体の健全性のために、機能が非推奨化、削除、またはより良いものに置き換えられる場合があります。 このプロセスの詳細については、Kubernetesの非推奨化と削除のポリシーをご覧ください。

古いDRA実装の廃止

KEP #3063により、Kubernetes 1.26でDynamic Resource Allocation(DRA)が導入されました。

しかし、Kubernetes v1.32では、このDRAのアプローチが大幅に変更されます。元の実装に関連するコードは削除され、KEP #4381が「新しい」基本機能として残ります。

既存のアプローチを変更する決定は、リソースの可用性が不透明であったことによるクラスターオートスケーリングとの非互換性に起因しており、これによりCluster Autoscalerとコントローラーの両方の意思決定が複雑化していました。 新しく追加されたStructured Parameterモデルがその機能を置き換えます。

この削除により、Kubernetesはkube-apiserverとの双方向のAPIコールの複雑さを回避し、新しいハードウェア要件とリソースクレームをより予測可能な方法で処理できるようになります。

詳細については、KEP #3063をご覧ください。

API削除

Kubernetes v1.32では、以下のAPIが削除されます:

- FlowSchemaとPriorityLevelConfigurationの

flowcontrol.apiserver.k8s.io/v1beta3APIバージョンが削除されます。 これに備えるため、既存のマニフェストを編集し、v1.29以降で利用可能なflowcontrol.apiserver.k8s.io/v1 APIバージョンを使用するようにクライアントソフトウェアを書き換えることができます。 既存の永続化されたオブジェクトはすべて新しいAPIを通じてアクセス可能です。flowcontrol.apiserver.k8s.io/v1beta3における主な変更点として、PriorityLevelConfigurationのspec.limited.nominalConcurrencySharesフィールドは未指定の場合にのみデフォルトで30となり、明示的に0が指定された場合は30に変更されないようになりました。

詳細については、API廃止に関する移行ガイドを参照してください。

リリースノートとアップグレードに必要なアクション

Kubernetes v1.32リリースの詳細については、リリースノートをご確認ください。

入手方法

Kubernetes v1.32は、GitHubまたはKubernetesダウンロードページからダウンロードできます。

Kubernetesを始めるには、対話式のチュートリアルをチェックするか、minikubeを使用してローカルKubernetesクラスタを実行してください。 また、kubeadmを使用して簡単にv1.32をインストールすることもできます。

リリースチーム

Kubernetesは、そのコミュニティのサポート、献身、そして懸命な努力に支えられて実現しています。 各リリースチームは、皆様が頼りにしているKubernetesリリースを構成する多くの要素を構築するために協力して働く、献身的なコミュニティボランティアで構成されています。 これには、コード自体からドキュメンテーション、プロジェクト管理に至るまで、コミュニティのあらゆる分野から専門的なスキルを持つ人々が必要です。

私たちは、Kubernetes v1.32リリースをコミュニティに提供するために多くの時間を費やしてくださったリリースチーム全体に感謝の意を表します。 リリースチームのメンバーは、初めてShadowとして参加する人から、複数のリリースサイクルを経験したベテランのチームリーダーまで多岐にわたります。 リリースリードのFrederico Muñozには、リリースチームを見事に率いて、あらゆる事柄を細心の注意を払って処理し、このリリースを円滑かつ効率的に実行してくれたことに、特別な感謝の意を表します。 最後になりましたが、すべてのリリースメンバー(リードとShadowの双方)、そして14週間のリリース作業期間中に素晴らしい仕事と成果を上げてくれた以下のSIGsに、大きな感謝の意を表します:

- SIG Docs - ドキュメントとブログのレビューにおける基本的なサポートを提供し、リリースのコミュニケーションとドキュメントチームとの継続的な協力を行ってくれました。

- SIG K8s InfraとSIG Testing - 必要なすべてのインフラコンポーネントと共に、テストフレームワークを確実に維持するための素晴らしい仕事を行ってくれました。

- SIG Releaseとすべてのリリースマネージャー - リリース全体の調整を通じて素晴らしいサポートを提供し、最も困難な課題でも適切かつタイムリーに対応してくれました。

プロジェクトの進捗速度

CNCFのK8s DevStatsプロジェクトは、Kubernetesと様々なサブプロジェクトの進捗に関する興味深いデータポイントを集計しています。 これには、個人の貢献から貢献している企業の数まで、このエコシステムの進化に関わる取り組みの深さと広さを示す様々な情報が含まれています。

14週間(9月9日から12月11日まで)続いたv1.32リリースサイクルでは、125の異なる企業と559の個人がKubernetesに貢献しました。

クラウドネイティブエコシステム全体では、433の企業から合計2441人の貢献者がいます。 これは前回のリリースサイクルと比較して、全体の貢献が7%増加し、参加企業数も14%増加したことを示しており、クラウドネイティブプロジェクトに対する強い関心とコミュニティの支持が表れています。

このデータの出典:

ここでの貢献とは、コミットの作成、コードレビュー、コメント、IssueやPRの作成、PR(ブログやドキュメントを含む)のレビュー、もしくはIssueやPRへのコメントを指します。

コントリビューターウェブサイトのGetting Startedから、貢献を始める方法をご確認ください。

Kubernetesプロジェクトとコミュニティの全体的な活動状況の詳細については、DevStatsをご確認ください。

イベント情報

2025年3月から6月にかけて開催予定のKubernetesとクラウドネイティブ関連のイベントをご紹介します。 KubeCon、KCD、その他世界各地で開催される注目のカンファレンスが含まれています。 Kubernetesコミュニティの最新情報を入手し、交流を深めましょう。

2025年3月

- KCD - Kubernetes Community Days: Beijing, China: 3月 | 北京(中国)

- KCD - Kubernetes Community Days: Guadalajara, Mexico: 2025年3月16日 | グアダラハラ(メキシコ)

- KCD - Kubernetes Community Days: Rio de Janeiro, Brazil: 2025年3月22日 | リオデジャネイロ(ブラジル)

2025年4月

- KubeCon + CloudNativeCon Europe 2025: 2025年4月1日-4日 | ロンドン(イギリス)

- KCD - Kubernetes Community Days: Budapest, Hungary: 2025年4月23日 | ブダペスト(ハンガリー)

- KCD - Kubernetes Community Days: Chennai, India: 2025年4月26日 | チェンナイ(インド)

- KCD - Kubernetes Community Days: Auckland, New Zealand: 2025年4月28日 | オークランド(ニュージーランド)

2025年5月

- KCD - Kubernetes Community Days: Helsinki, Finland: 2025年5月6日 | ヘルシンキ(フィンランド)

- KCD - Kubernetes Community Days: San Francisco, USA: 2025年5月8日 | サンフランシスコ(アメリカ)

- KCD - Kubernetes Community Days: Austin, USA: 2025年5月15日 | オースティン(アメリカ)

- KCD - Kubernetes Community Days: Seoul, South Korea: 2025年5月22日 | ソウル(韓国)

- KCD - Kubernetes Community Days: Istanbul, Turkey: 2025年5月23日 | イスタンブール(トルコ)

- KCD - Kubernetes Community Days: Heredia, Costa Rica: 2025年5月31日 | エレディア(コスタリカ)

- KCD - Kubernetes Community Days: New York, USA: 2025年5月 | ニューヨーク(アメリカ)

2025年6月

- KCD - Kubernetes Community Days: Bratislava, Slovakia: 2025年6月5日 | ブラチスラバ(スロバキア)

- KCD - Kubernetes Community Days: Bangalore, India: 2025年6月6日 | バンガロール(インド)

- KubeCon + CloudNativeCon China 2025: 2025年6月10日-11日 | 香港

- KCD - Kubernetes Community Days: Antigua Guatemala, Guatemala: 2025年6月14日 | アンティグア グアテマラ(グアテマラ)

- KubeCon + CloudNativeCon Japan 2025: 2025年6月16日-17日 | 東京(日本)

- KCD - Kubernetes Community Days: Nigeria, Africa: 2025年6月19日 | ナイジェリア

次期リリースに関するウェビナーのお知らせ

2025年1月9日(木)午後5時(太平洋時間) に開催されるKubernetes v1.32リリースチームメンバーによるウェビナーにご参加ください。 このリリースの主要な機能や、アップグレード計画に役立つ非推奨化および削除された機能について学ぶことができます。 詳細および参加登録については、CNCFオンラインプログラムサイトのイベントページをご覧ください。

参加方法

Kubernetesに関わる最も簡単な方法は、あなたの興味に合ったSpecial Interest Groups(SIG)のいずれかに参加することです。 Kubernetesコミュニティに向けて何か発信したいことはありますか? 毎週のコミュニティミーティングや、以下のチャンネルであなたの声を共有してください。 継続的なフィードバックとサポートに感謝いたします。

- 最新情報はBlueskyの@Kubernetes.ioをフォローしてください

- Discussでコミュニティディスカッションに参加してください

- Slackでコミュニティに参加してください

- Stack Overflowで質問したり、回答したりしてください

- あなたのKubernetesに関するストーリーを共有してください

- Kubernetesの最新情報はブログでさらに詳しく読むことができます

- Kubernetesリリースチームについてもっと学んでください

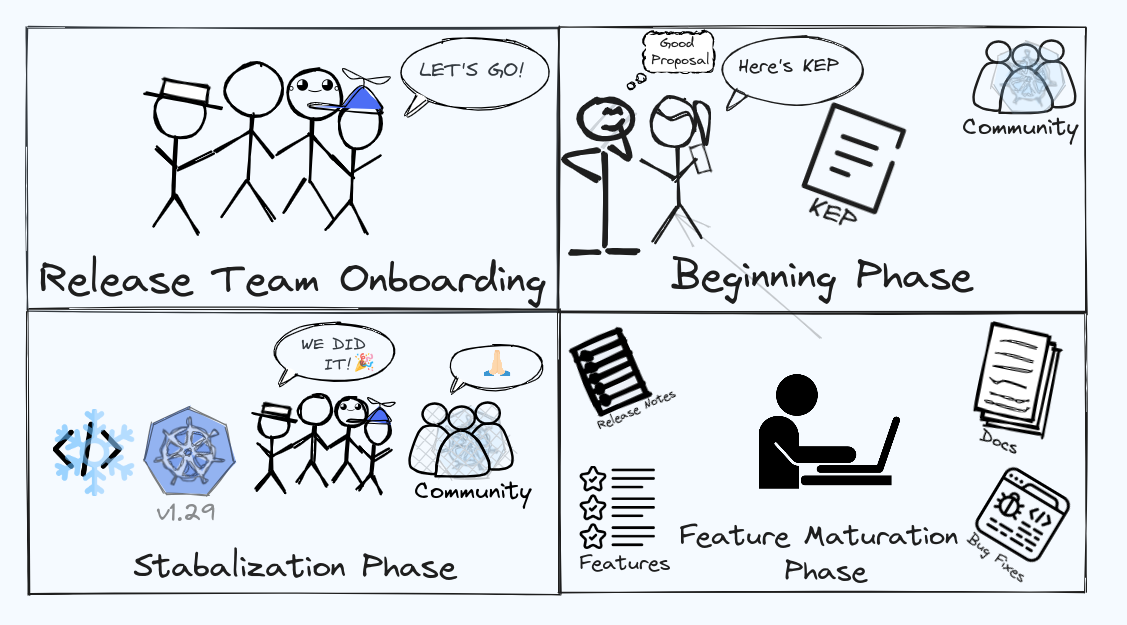

Kubernetes Upstream Training in Japanの取り組みの紹介

私たちは、Kubernetes Upstream Training in Japanのオーガナイザーチームです。 チームは、Kubernetesへのコントリビューションを続けるメンバーで構成され、その中にはReviewerやApprover、Chairといった役割を担う人々も含まれています。

私たちの目標は、Kubernetesのコントリビューターを増やし、コミュニティの成長を促進することです。Kubernetesコミュニティは親切で協力的ですが、初めての貢献はややハードルが高いと感じる方もいます。私たちのトレーニングプログラムは、そのハードルを下げ、初心者でもスムーズに参加できる環境を提供することを目的としています。

Kubernetes Upstream Training in Japanとは?

Kubernetes Upstream Training in Japanは2019年から始まり、年に1〜2回のペースで開催されています。 当初、Kubernetes Upstream TrainingはKubeConのco-locatedイベント(Kubernetes Contributor Summit)の中で実施されていましたが、同様のイベントを日本でも行って日本人のコントリビューターを増やしたいという思いから、私たちはKubernetes Upstream Training in Japanを立ち上げました。

パンデミック以前は対面形式で行われていましたが、2020年以降はオンラインで開催しています。 トレーニングでは、Kubernetesにまだコントリビューションをしたことがない方々に向けて、以下のような内容を提供しています。

- Kubernetesコミュニティの紹介

- Kubernetesのコードベースの紹介と、PRの作成方法

- 言語など参加障壁を低減するための工夫や勇気付け

- 開発環境のセットアップ方法

- kubernetes-sigs/contributor-playgroundを使用したハンズオン

プログラムの最初に、なぜKubernetesにコントリビューションするのか、だれがKubernetesにコントリビューションできるのかを伝えます。 Kubernetesに貢献することは、世界中にインパクトのある貢献ができること、そしてKuberenetesコミュニティはみなさんからのコントリビューションを楽しみにしていることを伝えます!

KubernetesコミュニティやSIG、Working Groupについて説明します。 また、私たちが主にコミュニケーションのために用いるSlackやGitHub、メーリングリストについて説明します。 日本語を話す人の中には、英語によるコミュニケーションに障壁を感じる人もいます。 また、コミュニティに初めて参加する人は、どこでどのようなコミュニケーションが行われているのか知る必要があります。 もちろん、私たちがトレーニングの中で最も大切にしていることは第一歩を踏み出すことです!

次に、Member、Reviewer、Approver、Tech leadやChairといった役割や責任について説明します。

その後、Kubernetesのコードベースの構成、主要なリポジトリ、PRの作成方法、Prowを使ったCI/CDの仕組みなどを解説します。 PRが作成されてからマージされるまでのプロセスについて詳しく説明します。

いくつかの講義を行った後、実際に参加者には、kubernetes-sigs/contributor-playgroundを使用したハンズオンを行い、簡単なPRの作成を体験してもらいます。 これにより、Kubernetesへのコントリビューションの流れを実感してもらうことが目的です。

プログラムの最後には、ローカルでのクラスター構築、コードのビルド、効率的なテスト実行方法など、kubernetes/kubernetesリポジトリに貢献するための具体的な開発環境のセットアップについても解説します。

参加者へのインタビュー

私たちのトレーニングプログラムに参加した方々にインタビューを行いました。 参加した理由や感想、そして今後の目標について伺いました。

Keita Mochizukiさん(NTT DATA Group Corporation)

Keita Mochizukiさんは、Kubernetesや周辺のプロジェクトへ継続的に貢献しているコントリビューターです。 Keitaさんは、コンテナセキュリティのプロフェッショナルでもあり、最近は書籍の出版を行いました。 また、新規コントリビューターのためのロードマップを公開しており、これは新たなコントリビューターにとって非常に役立つものです。

Junya: なぜKubernetes Upstream Trainingに参加しようと思いましたか?

Keita: 実は私は2020年と2022年の2回参加しました。2020年はk8sに触れ始めたばかりで、社外活動に参加してみようと思い、偶然Twitterで見かけて申し込みました。しかし、当時は知識も浅く、OSSにPRを送ること自体が雲の上の存在のように感じていました。そのため、受講後の理解度は浅く、なんとなく「ふーん」という感覚でした。

2回目の2022年は、具体的にコントリビューションを始めようとしていたタイミングで、再度参加しました。この時は事前調査も行い、疑問点を講義中に解決できたので、非常に実りある時間を過ごせました。

Junya: 参加してみて、どのような感想を持ちましたか?

Keita: このトレーニングは参加者のスタンス次第でその意義が大きく変わるものだと感じました。トレーニング自体は一般的な解説と簡単なハンズオンで構成されていますが、このトレーニングに参加したからといって、すぐにコントリビューションができるかというと、そう簡単ではありません。しかし、もし事前に自分が今後コントリビューションを行うイメージをなんとなくでも持っていたり、具体的な疑問や課題を明確にしておくことができれば、講師の方々が実際にコミュニティで培った貴重なノウハウを活かして、それらに対して丁寧に応えてくれるため、大変有意義なトレーニングになると思います。

Junya: コントリビューションの目的は何ですか?

Keita: 最初のモチベーションは「Kubernetesの深い理解と実績の獲得」で、つまり「コントリビューションそのものが目的」でした。 現在はこれに加え、業務で発見したバグや制約への対応を目的にコントリビューションを行うこともあります。また、コントリビューション活動を通じて、ドキュメント化されていない仕様をソースコードから解析することへの抵抗が以前よりも少なくなりました。

Junya: コントリビューションをする中で、難しかったことは何ですか?

Keita: 最も難しかったのは、最初の一歩を踏み出すことでした。OSSへのコントリビューションには一定の知識やノウハウが必要となるため、本トレーニングをはじめ、さまざまなリソースの活用や人からのサポートが不可欠でした。その中で、「最初の一歩を踏み出すと、あとはどんどん前に進める」という言葉が強く印象に残っています。また、業務としてコントリビューションを続ける上で一番難しいのは、その成果を業績として示すことです。継続的に取り組むためには事業目標や戦略と関連付ける必要がありますが、UpstreamへのContributionは必ずしも短期的に業績に繋がるケースばかりではないため、そのことをマネージャーと十分に認識を合わせ、理解を得ることが重要であると考えています。

Junya: 今後の目標は何ですか?

Keita: よりインパクトのある領域にコントリビューションすることです。これまでは実績を得ることを主目的としていたため比較的小さな個々のバグ等を中心にコントリビューションを行うことが多かったのですが、今後はKubernetesのユーザーに対して影響度の高いものや、業務上の課題解決に繋がるものに挑戦の幅を広げたいと思っています。最近は自身がコードベースの開発や修正に携わった内容を公式ドキュメントに反映すると言うことも行っていますが、これも目標に向けての1歩だと考えています。

Junya: ありがとうございました!

Yoshiki Fujikaneさん(CyberAgent, Inc.)

Yoshiki Fujikaneさんは、CNCFのSandboxプロジェクトのひとりであるPipeCDのメンテナのひとりです。 PipeCDのKubernetesサポートに関する新機能の開発の他に、コミュニティ運営や、各種技術カンファレンスへの登壇も積極的に行っています。

Junya: なぜKubernetes Upstream Trainingに参加しようと思いましたか?

Yoshiki: 参加した当時はまだ学生時代でした。その時はEKSを軽く触っていただけでしたが、なんか難しいけどかっこいいな!とk8s自体に興味をふんわりと持っている状態でした。当時は本当にOSSは雲の上の存在で、ましてやk8sのupstreamの開発なんてすごすぎて手の届かない存在だと思ってました。OSSにはもともと興味があったのですが、何から始めればいいのかわからなかったです。そんな時にkubernetes upstream trainingの存在を知って、k8sへのコントリビューションに挑戦してみようと思いました。

Junya: 参加してみて、どのような感想を持ちましたか?

Yoshiki: OSSに関わるコミュニティがどんなものかを知るキッカケとしてとてもありがたいなと感じました。当時は英語力もそこまで高くなく、一次情報を見に行くことは自分にとって大きなハードルでした。 k8sは非常に大きなプロジェクトなので、コントリビューションに必要なことだけでなく、全体像があまりわかっていない状態でした。upstream trainingでは、コミュニティの構造を日本語で説明していただいたうえで、コントリビューションを実際に行うところまで一通り経験することができました。そこで、一次情報に関する情報を共有してくださったおかげで、その後自分なりにエントリーポイントとして利用しつつ追加で調査するキッカケづくりになって非常にありがたかったです。この経験から、一次情報を整理しつつ見る習慣を身につける必要があるなと思い、気になったものはGitHubのissueやdocsを漁りに見に行くようになりました。結果として、今はk8sのコントリビューション自体は行っていませんが、ここでの経験が別プロジェクトにコントリビューションするための素地となって役立っています。

Junya: 現在はどのような領域でコントリビューションを行っていますか?別のプロジェクトとはどのようなものでしょうか?

Yoshiki: 現在はk8sからは少し離れていて、CNCFのSandbox ProjectであるPipeCDのメンテナをやっています。PipeCDはCDツールの一つで、様々なアプリケーションプラットフォームに対してGitOpsスタイルでデプロイする機能を持っています。このツールは、元々サイバーエージェント内部で開発が始まりました。大小様々なチームが異なるプラットフォームを採用していた中で、統一的なUXで共通で利用できるCD基盤を実現するために開発が進められた背景があります。現在はk8s、AWS ECS、Lambda、Cloud Run、Terraformといったプラットフォームに対応しています。

Junya: PipeCDチームの中ではどのような役割ですか?

Yoshiki: 私はチーム内ではk8s周りの機能改善、開発をフルタイムの仕事として行っています。社内向けにPipeCDをSaaSとして提供しているため、そのサポートの一環として、新規機能の追加や既存機能の改善などを行うことが主な目的です。さらに、コード以外のコントリビューションとしては、PipeCD自体のコミュニティ拡大に向けて各種登壇であったり、コミュニティミーティングの運営を行っているところです。

Junya: Kubernetes周りの機能改善や開発とは具体的にどのようなものですか?

Yoshiki: PipeCDはKubernetesのGitOpsやProgressive Deliveryをサポートしていて、それらの機能開発などです。直近だと、マルチクラスタ上へのデプロイを効率化するための機能開発を進めているところです。

Junya: OSSコントリビューションを行うなかで、難しかったことはありますか?

Yoshiki: 機能の汎用性を維持しつつ、ユーザのユースケースを満たすように開発を進めることです。社内SaaSを運用する中で機能要望をいただいた際には、もちろん課題を解決するためにまずは機能追加を検討します。一方で、PipeCDはOSSとしてより多くのユーザに使ってもらうことも考えて行きたいです。なので、あるユースケースをもとに別のユースケースとしても使えるかどうかを考え、ソフトウェアとして汎用性をもたせるように意識しています。

Junya: 今後の目標を教えてください!

Yoshiki: PipeCDの機能拡張に力を入れていきたいと考えています。PipeCDは現在One CD for All のスローガンのもと開発を進めています。先程お伝えした通り、k8s、AWS ECS、Lambda、Cloud Run、Terraform の5種類に対応していますが、これ以外にもプラットフォームは存在しますし、今後も新たなプラットフォームが台頭してくるかもしれません。そこで、PipeCDは現在ユーザが独自に拡張できるようにプラグイン機構の開発を進めています。それに力を入れていきたいですね。また、k8sのマルチクラスタデプロイ向けの機能開発も進めているところで、これからもよりインパクトのあるコントリビューションをしていきたいと考えてます。

Junya: ありがとうございました!

Kubernetes Upstream Training の未来

私たちは、これからもKubernetes Upstream Training in Japanを継続して開催し、多くの新しいコントリビューターを迎えたいと考えています。 次回の開催は11月末のCloudNative Days Winter 2024の中での開催を予定しています。

また、私たちの目標は、これらのトレーニングプログラムを日本だけでなく、世界中に広げていくことです。 Kubernetesは今年で10周年を迎えましたが、コミュニティがこれまで以上に活発になるためには、世界中の人々が貢献し続けることが重要です。 現在、Upstream Trainingはいくつかの地域で開催されていますが、私たちはさらに多くの地域での開催を目指しています。

多くの人々がKubernetesコミュニティに参加し、貢献することで、私たちのコミュニティがますます活気づくことを楽しみにしています!

Kubernetes 1.31: Fine-grained SupplementalGroups control

この記事ではKubernetes 1.31の新機能である、Pod内のコンテナにおける補助グループ制御の改善機能について説明します。

動機: コンテナイメージ内の/etc/groupに定義される暗黙的なグループ情報

この挙動は多くのKubernetesクラスターのユーザー、管理者にとってあまり知られていないかもしれませんが、Kubernetesは、デフォルトでは、Podで定義された情報に加えて、コンテナイメージ内の/etc/groupのグループ情報を マージ します。

例を見てみましょう。このPodはsecurityContextでrunAsUser=1000、runAsGroup=3000、supplementalGroups=4000を指定しています。

apiVersion: v1

kind: Pod

metadata:

name: implicit-groups

spec:

securityContext:

runAsUser: 1000

runAsGroup: 3000

supplementalGroups: [4000]

containers:

- name: ctr

image: registry.k8s.io/e2e-test-images/agnhost:2.45

command: [ "sh", "-c", "sleep 1h" ]

securityContext:

allowPrivilegeEscalation: false

ctrコンテナでidコマンドを実行すると何が出力されるでしょうか?

# Podを作成してみましょう。

$ kubectl apply -f https://k8s.io/blog/2024-08-22-Fine-grained-SupplementalGroups-control/implicit-groups.yaml

# Podのコンテナが実行されていることを確認します。

$ kubectl get pod implicit-groups

# idコマンドを確認します。

$ kubectl exec implicit-groups -- id

出力は次のようになるでしょう。

uid=1000 gid=3000 groups=3000,4000,50000

Podマニフェストには50000は一切定義されていないにもかかわらず、補助グループ(groupsフィールド)に含まれているグループID50000は一体どこから来るのでしょうか? 答えはコンテナイメージの/etc/groupファイルです。

コンテナイメージの/etc/groupの内容が下記のようになっていることが確認できるでしょう。

$ kubectl exec implicit-groups -- cat /etc/group

...

user-defined-in-image:x:1000:

group-defined-in-image:x:50000:user-defined-in-image

なるほど!コンテナのプライマリユーザーであるユーザー(1000)がグループ(50000)に属していることが最後のエントリから確認出来ました。

このように、コンテナイメージ上の/etc/groupで定義される、コンテナのプライマリユーザーのグループ情報は、Podからの情報に加えて 暗黙的にマージ されます。ただし、この挙動は、現在のCRI実装がDockerから引き継いだ設計上の決定であり、コミュニティはこれまでこの挙動について再検討することはほとんどありませんでした。

何が悪いのか?

コンテナイメージの/etc/groupから 暗黙的にマージ されるグループ情報は、特にボリュームアクセスを行う際に、セキュリティ上の懸念を引き起こすことがあります(詳細はkubernetes/kubernetes#112879を参照してください)。なぜなら、Linuxにおいて、ファイルパーミッションはuid/gidで制御されているからです。更に悪いことに、/etc/groupに由来する暗黙的なgidは、マニフェストにグループ情報の手がかりが無いため、ポリシーエンジン等でチェック・検知をすることが出来ません。これはKubernetesセキュリティの観点からも懸念となります。

PodにおけるFine-grained(きめ細かい) SupplementalGroups control: SupplementaryGroupsPolicy

この課題を解決するために、Kubernetes 1.31はPodの.spec.securityContextに、新しくsupplementalGroupsPolicyフィールドを追加します。

このフィールドは、Pod内のコンテナプロセスに付与される補助グループを決定するを方法を制御できるようにします。有効なポリシーは次の2つです。

-

Merge:

/etc/groupで定義されている、コンテナのプライマリユーザーが所属するグループ情報をマージします。指定されていない場合、このポリシーがデフォルトです(後方互換性を考慮して既存の挙動と同様)。 -

Strict:

fsGroup、supplementalGroups、runAsGroupフィールドで指定されたグループIDのみ補助グループに指定されます。つまり、/etc/groupで定義された、コンテナのプライマリユーザーのグループ情報はマージされません。

では、どのようにStrictポリシーが動作するか見てみましょう。

apiVersion: v1

kind: Pod

metadata:

name: strict-supplementalgroups-policy

spec:

securityContext:

runAsUser: 1000

runAsGroup: 3000

supplementalGroups: [4000]

supplementalGroupsPolicy: Strict

containers:

- name: ctr

image: registry.k8s.io/e2e-test-images/agnhost:2.45

command: [ "sh", "-c", "sleep 1h" ]

securityContext:

allowPrivilegeEscalation: false

# Podを作成してみましょう。

$ kubectl apply -f https://k8s.io/blog/2024-08-22-Fine-grained-SupplementalGroups-control/strict-supplementalgroups-policy.yaml

# Podのコンテナが実行されていることを確認します。

$ kubectl get pod strict-supplementalgroups-policy

# プロセスのユーザー、グループ情報を確認します。

kubectl exec -it strict-supplementalgroups-policy -- id

出力はこのようになります。

uid=1000 gid=3000 groups=3000,4000

Strictポリシーによってグループ50000がgroupsから除外されているのが確認できました!

このように、確実にsupplementalGroupsPolicy: Strictを設定する(ポリシーエンジン等によって強制する)ことで、暗黙的な補助グループを回避することが可能になります。

備考:

このフィールドの値を強制するだけでは不十分な場合もあります。なぜなら、プロセスが自分自身のユーザー、グループ情報を変更できる権限/ケーパビリティを持っている場合があるからです。詳細は次のセクションを参照してください。Podステータスにおける付与されたユーザー、グループ情報の確認

この機能は、Podのstatus.containerStatuses[].user.linuxフィールドでコンテナの最初のプロセスに付与されたユーザー、グループ情報を公開しています。暗黙的なグループIDが付与されているかどうかを確認するのに便利でしょう。

...

status:

containerStatuses:

- name: ctr

user:

linux:

gid: 3000

supplementalGroups:

- 3000

- 4000

uid: 1000

...

備考:

status.containerStatuses[].user.linuxフィールドで公開されているユーザー、グループ情報は、コンテナの最初のプロセスに、最初に付与された 情報であることに注意してください。

もしそのプロセスが、自身のユーザー、グループ情報を変更できるシステムコール(例えば setuid(2),

setgid(2),

setgroups(2)等)を実行する権限を持っている場合、プロセス自身で動的に変更が可能なためです。

つまり、実際にプロセスに付与されているユーザー、グループ情報は動的に変化します。この機能を利用するには

supplementalGroupsPolicyフィールドを有効化するには、下記のコンポーネントを利用する必要があります。

- Kubernetes: v1.31以降、かつ、

SupplementalGroupsPolicyフィーチャーゲートが有効化されていること。v1.31現在、このフィーチャーゲートはアルファです。 - CRI実装:

- containerd: v2.0以降

- CRI-O: v1.31以降

ノードの.status.features.supplementalGroupsPolicyフィールドでこの機能が利用可能かどうか確認出来ます。

apiVersion: v1

kind: Node

...

status:

features:

supplementalGroupsPolicy: true

将来の展望

Kubernetes SIG Nodeは、この機能が将来的なKubernetesのリリースでベータ版に昇格し、最終的には一般提供(GA)されることを望んでおり、期待しています。そうなれば、ユーザーはもはや機能ゲートを手動で有効にする必要がなくなります。

supplementalGroupsPolicyが指定されていない場合は、後方互換性のためにMergeポリシーが適用されます。

より学ぶには?

- Podとコンテナにセキュリティコンテキストを設定する(

supplementalGroupsPolicyの詳細) - KEP-3619: Fine-grained SupplementalGroups control

参加するには?

この機能はSIG Nodeコミュニティによって推進されています。コミュニティに参加して、上記の機能やそれ以外のアイデアやフィードバックを共有してください。皆さんからのご意見をお待ちしています!

Kubernetes 1.31: SPDYからWebSocketへのストリーミングの移行

Kubernetes 1.31では、kubectlがストリーミングする際に、SPDYに代わりWebSocketプロトコルをデフォルトで使用するようになりました。

この記事では、この変更が意味するところと、なぜこれらのストリーミングAPIが重要なのかについて説明します。

KubernetesのストリーミングAPI

Kubernetesでは、HTTPまたはRESTfulインターフェースとして公開される特定のエンドポイントが、ストリーミングプロトコルが必要な、ストリーミング接続にアップグレードされます。 リクエスト・レスポンス型プロトコルであるHTTPとは異なり、ストリーミングプロトコルは双方向・低遅延の永続的な接続を提供し、リアルタイムでの対話を可能にします。 ストリーミングプロトコルは、クライアントとサーバー間で同一の接続を介して、双方向でのデータの読み書きをサポートします。 このタイプの接続は、例えば、ローカルワークステーションから実行中のコンテナ内にシェルを作成し、そのコンテナ内でコマンドを実行する場合などに役立ちます。

なぜストリーミングプロトコルを変更するのか?

v1.31リリース以前は、Kubernetesはストリーミング接続をアップグレードする際に、デフォルトでSPDY/3.1プロトコルを使用していました。

SPDY/3.1は8年前に非推奨となっており、標準化されることはありませんでした。

多くの最新のプロキシ、ゲートウェイ、ロードバランサーは、このプロトコルをサポートしていません。

その結果、プロキシやゲートウェイを介してクラスターにアクセスしようとすると、kubectl cp、kubectl attach、kubectl exec、kubectl port-forwardなどのコマンドが機能しなくなることがあります。

Kubernetes v1.31以降、SIG API Machineryは、Kubernetesクライアント(kubectlなど)がこれらのコマンドに使用するストリーミングプロトコルを、よりモダンなWebSocketストリーミングプロトコルに変更しました。

WebSocketプロトコルは、現在サポートされている標準化されたストリーミングプロトコルであり、様々なコンポーネントやプログラミング言語間の互換性と相互運用性を保証します。

WebSocketプロトコルは、SPDYよりも最新のプロキシやゲートウェイで広くサポートされています。

ストリーミングAPIの仕組み

Kubernetesは、発信元のHTTPリクエストに特定のアップグレードヘッダーを追加することで、HTTP接続をストリーミング通信が可能な接続へと切り替えます。

例えば、クラスター内のnginxコンテナでdateコマンドを実行するためのHTTPアップグレードリクエストは、以下のようになります:

$ kubectl exec -v=8 nginx -- date

GET https://127.0.0.1:43251/api/v1/namespaces/default/pods/nginx/exec?command=date…

Request Headers:

Connection: Upgrade

Upgrade: websocket

Sec-Websocket-Protocol: v5.channel.k8s.io

User-Agent: kubectl/v1.31.0 (linux/amd64) kubernetes/6911225

コンテナランタイムがWebSocketストリーミングプロトコルと、少なくとも1つのサブプロトコルバージョン(例:v5.channel.k8s.io)をサポートしている場合、サーバーは成功を示す101 Switching Protocolsステータスと、ネゴシエートされたサブプロトコルバージョンを含めて応答します:

Response Status: 101 Switching Protocols in 3 milliseconds

Response Headers:

Upgrade: websocket

Connection: Upgrade

Sec-Websocket-Accept: j0/jHW9RpaUoGsUAv97EcKw8jFM=

Sec-Websocket-Protocol: v5.channel.k8s.io

この時点で、HTTPプロトコルに使用されていたTCP接続はストリーミング接続に変更されています。 この対話型シェルでのSTDIN、STDOUT、STDERR(ターミナルのリサイズ情報やプロセス終了コードも含む)データは、このアップグレードされた接続を通じてストリーミングされます。

新しいWebSocketストリーミングプロトコルの使用方法

クラスターとkubectlがバージョン1.29以降の場合、SPDYではなくWebSocketの使用を制御するための、2つのコントロールプレーンフィーチャーゲートと2つのkubectl環境変数があります。 Kubernetes 1.31では、以下のすべてのフィーチャーゲートがベータ版であり、デフォルトで有効になっています:

- フィーチャーゲート

TranslateStreamCloseWebsocketRequests.../exec.../attach

PortForwardWebsockets.../port-forward

- kubectlの機能を制御する環境変数

KUBECTL_REMOTE_COMMAND_WEBSOCKETSkubectl execkubectl cpkubectl attach

KUBECTL_PORT_FORWARD_WEBSOCKETSkubectl port-forward

古いバージョンのクラスターにおいても、フィーチャーゲート設定を管理できる場合であれば、TranslateStreamCloseWebsocketRequests(Kubernetes v1.29で追加)とPortForwardWebsockets(Kubernetes v1.30で追加)の両方を有効にして、この新しい動作を試すことができます。

バージョン1.31のkubectlは自動的に新しい動作を使用できますが、サーバー側の機能が明示的に有効になっているクラスターに接続する必要があります。

ストリーミングAPIについてさらに学ぶ

Kubernetes v1.31: キャッシュからの整合性のある読み込みによるクラスターパフォーマンスの向上

Kubernetesはコンテナ化されたアプリケーションの堅牢なオーケストレーションで知られていますが、クラスターの規模が拡大するにつれて、コントロールプレーンへの負荷がボトルネックとなる可能性があります。 特に大きな課題となっていたのは、etcdデータストアからのデータ読み込みの厳密な整合性を保証することです。 これを実現するには、リソースを大量に消費するクォーラム読み込みが必要でした。

本日、Kubernetesコミュニティは、大きな改善を発表できることを嬉しく思います。 Kubernetes v1.31において、「キャッシュからの整合性のある読み込み」がベータ版に移行しました。

なぜ整合性のある読み込みが重要なのか

Kubernetes コンポーネントがクラスターの最新状態を正確に把握するためには、整合性のある読み込みが不可欠です。 整合性のある読み込みを保証することで、Kubernetesの操作の正確性と信頼性が維持され、各コンポーネントは最新の情報に基づいて適切な判断を下すことができます。 しかし、大規模なクラスターでは、そのためのデータの取得と処理がパフォーマンスのボトルネックとなるおそれがあります。 特に、結果のフィルタリングを伴うリクエストでこの問題が顕著になります。 Kubernetesはetcd内で名前空間ごとにデータを直接フィルタリングできますが、ラベルやフィールドセレクタによるその他のフィルタリングでは、データセット全体をetcdから取得し、Kubernetes APIサーバーがメモリ上でフィルタリングを行う必要があります。 この問題は、特にkubeletなどのコンポーネントに大きな影響を与えます。 kubeletは自身のノードにスケジュールされたPodのみをリストするだけで足りるところを、これまでの仕組みでは、APIサーバーとetcdがクラスター内のすべてのPodを処理する必要がありました。

ブレイクスルー: 信頼性の高いキャッシング

Kubernetesは、読み込み操作を最適化するために、以前からWatchキャッシュを使用してきました。 Watchキャッシュはクラスターの状態のスナップショットを保存し、etcdのWatchを通じて更新情報を受け取ります。 しかし、これまではキャッシュが完全に最新の状態であることを保証できなかったため、整合性のある読み込みを直接提供することができませんでした。

「キャッシュからの整合性のある読み込み」機能は、etcdの進捗通知のメカニズムを活用してこの問題に対処します。 この通知により、Watchキャッシュは自身とetcdを比較し、データが最新かどうかを把握できます。 整合性のある読み込みが要求されると、システムはまずWatchキャッシュの内容が最新かどうかを確認します。 キャッシュが最新でない場合、システムはキャッシュの内容が完全に更新されたと確認できるまで、etcdに進捗通知を問い合わせ続けます。 そして準備が整うと、要求されたデータはキャッシュから直接読み取られ効率的に提供されます。 このため、特にetcdから大量のデータを取得する必要があるような場面で、パフォーマンスを大幅に向上させることができます。 以上のようにして、データをフィルタリングするリクエストをキャッシュから処理できるようになり、etcdから読み取る必要のあるメタデータは最小限に抑えられます。

重要な注意点: この機能を利用するには、Kubernetesクラスタでetcdバージョン3.4.31以降または3.5.13以降を実行している必要があります。 古いバージョンのetcdを使用している場合、etcdから直接整合性のある読み込みを行う方式に自動で切り替わります。

体感できるパフォーマンスの向上

この一見単純な変更は、Kubernetesのパフォーマンスとスケーラビリティに大きな影響を与えます。

- etcdの負荷軽減: Kubernetes v1.31では、etcdの作業負荷を軽減し、他の重要な操作のためにリソースを解放できます。

- レイテンシの短縮: キャッシュからの読み込みは、etcdからデータを取得して処理するよりもはるかに高速です。 これはコンポーネントへの応答が迅速になり、クラスター全体の応答性が向上することを意味します。

- スケーラビリティの向上: etcdの負荷軽減により、コントロールプレーンはパフォーマンスを犠牲にすることなくより多くのリクエストを処理できるようになるため、 数千ものノードとPodを持つような大規模なクラスターでは、最も大きなメリットが得られます。